IA et pédagogie : un état de l’art

Résumé

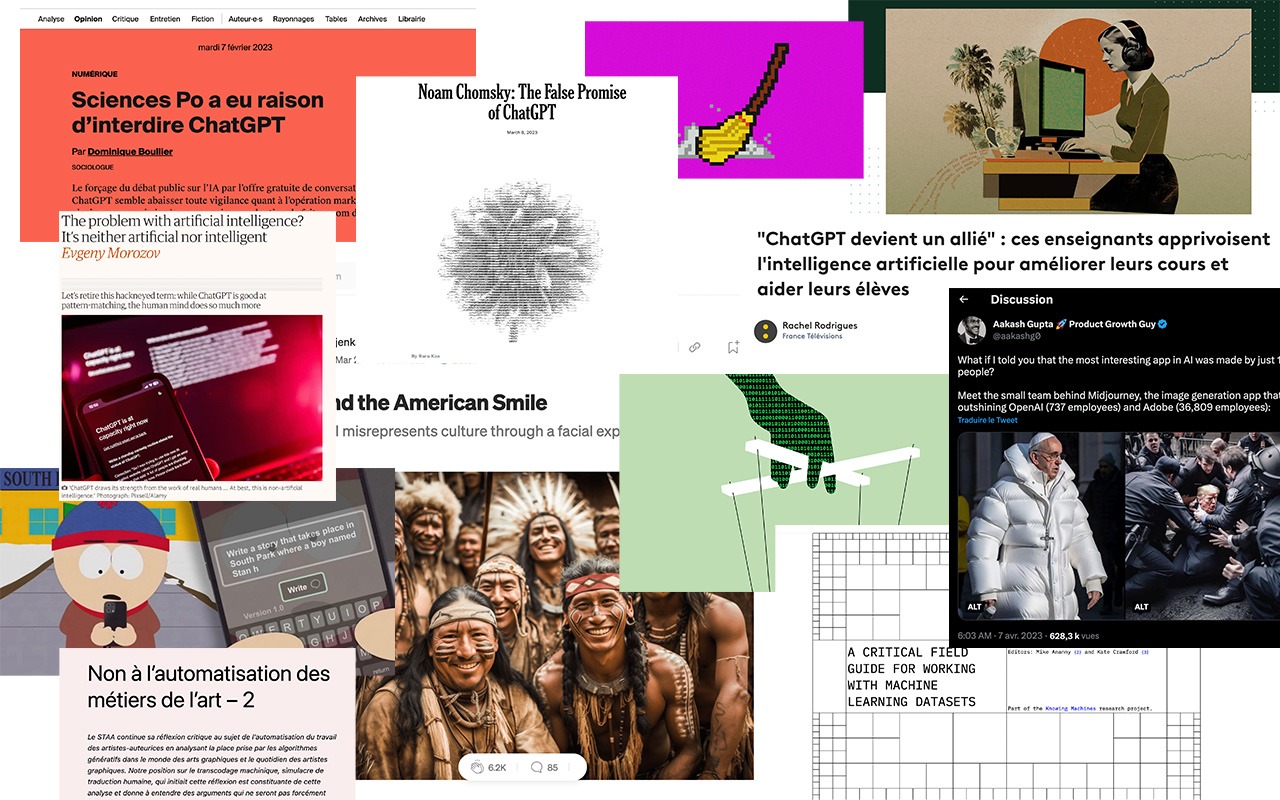

Cet état de l’art propose d’examiner une sélection de ressources traitant des enjeux pédagogiques des « intelligences [dites] artificielles » contemporaines. Apparues pour le grand public avec le lancement de services orientés divertissement et création tels que DALL·E (janvier 2021), Midjourney (juillet 2022) ou ChatGPT (novembre 2022), les technologies du machine learning (apprentissage automatique) permettent d’automatiser la production d’objets numériques tels que du texte, des images, mais aussi du son, de la vidéo ou de la 3D — ce qui oblige à repenser les compétences à enseigner et les façons de les évaluer. Cette initiative vise ainsi à poser, de façon éclairée, les termes d’un débat de fond quant à la place des IA en milieu scolaire afin de préfigurer des formats de cours, exercices et projets de recherche contributifs.

Cadre d’analyse

Nous avons fait le choix de concentrer nos efforts sur des ressources à caractère théorique, philosophique et/ou épistémologique, qui ont pour vertu de ne pas être obsolètes à (très ?) court terme car elles pointent des enjeux de fond liés à la structure et à l’économie de ces techniques. En effet, la place des IA en contexte pédagogique est compliquée à établir en raison (entre autres) du caractère opaque et privatisé des technologies du machine learning, de même que de leurs biais et limites. Certains articles abordent directement la place de la pédagogie, tandis que d’autres pointent des enjeux plus généraux. La plupart des textes abordent le cas de ChatGPT en raison de la popularité de ce dernier et de ses nombreux usages en milieu scolaire. À titre personnel, cet état de l’art prolonge la publication, en mars 2023, de l’essai Design sous artifice : la création au risque du machine learning produit dans le cadre d’un projet de recherche soutenu par la HES-SO.

Pour chaque item, nous avons isolé les idées clés du texte (déroulables via les boutons ci-dessous pour rendre l’ensemble plus lisible) et en avons établi une synthèse. Afin de coller au plus près à l’actualité des services étudiés, et contrairement à une bibliographie classique, les items sont classés par ordre chronologique (du plus récent au plus ancien), et non pas par ordre alphabétique (du nom de l’auteur·trice). Le repérage des textes a, de façon générale, été effectué sur Twitter par Anthony Masure, avec le soutien de Frank Adebiaye (@fadebiaye). L’analyse de base a été effectuée par Florie Souday (stagiaire au sein de l’Institut de recherche en art & design de la HEAD – Genève de avril à juin 2023) et a été revue par Anthony Masure. Dans la mesure du temps disponible, d’autres items augmenteront cette liste.

Notons enfin que les services analysés dans ces ressources nécessitent, de plus, d’effectuer une veille technique régulière (voire quotidienne) car les bases de données et algorithmes de traitement (et les services qui y sont associés) évoluent régulièrement. Par exemple, le modèle de langage GPT-3 (acronyme de « Generative Pre-trained Transformer ») d’OpenAI (mai 2020) aurait été entraîné avec 175 milliards de paramètres, contre 170 000 milliards pour GPT-4 (mars 2023). Ce ne sera pas le moindre des défis posés par les IA que de conjuguer le temps long de la recherche avec les promesses de rendement de ces services et le sentiment d’urgence qui s’en suit.

Synthèse de l’état de l’art

L’actuel engouement médiatique autour des IA grand public reflète de profondes scissions dans leur acceptation, avec des titres « chocs » les décrivant tantôt comme des « machines surpuissantes », tantôt comme des « machines aliénantes ». Or cette vision manichéenne de l’IA, nourrie par des discours plus anciens liés à la peur de l’automatisation de l’humain par la machine, doit être analysée plus finement. Plusieurs articles analysés dans cet état de l’art posent ainsi les questions suivantes :

– Quelle place les IA occupe(ro)nt-elles dans le monde social ?

– Comment augmenter, et non pas remplacer, l’intellect humain ?

– Est-il juste de réduire les IA à de pures machines aliénantes, dont l’opacité servirait à mieux contrôler les individus ?

– Qui sont les entités et groupes derrière ces IA ?

– La création va-t-elle disparaître au profit de contenus générés par les algorithmes ?

– Quelles sont les conséquences actuelles et potentielles des IA dans l’enseignement, et comment encadrer leur utilisation ?

– Comment l’enseignement peut-il s’adapter et intégrer (sans pour autant se laisser surpasser) par ces algorithmes ?

Le lancement de ChatGPT en 2022 par OpenAI, société existante depuis 2015 et créée par Elon Musk et Sam Altman, bouleverse la place de l’humain dans les institutions existantes. On a souvent tendance à pointer du doigt les dirigeants et ingénieurs des grandes entreprises comme uniques responsables. Or les systèmes alternatifs (décentralisés et fragmentés) du machine learning nuancent ces accusations à sens unique. Les États et les individus prennent également part au développement de ces algorithmes, en interagissant avec ou en décidant ou non d’interdire leurs usages. En somme, au lieu de chercher qui ou « quoi » responsabiliser, ne vaudrait-il pas mieux débattre, comprendre les limites, et trouver les failles de ces IA pour les contourner et apprendre à travailler « avec » d’une façon juste et éclairée ?

Ces programmes sont déjà implémentés dans des métiers créatifs (comme dans l’animation et la musique) ou utilisés par de nombreux étudiants pour accélérer leur travail. Il est dès lors primordial de rappeler que ces IA puisent leur force dans la création et l’intellect humains. Il importe de débattre, d’argumenter et d’analyser leurs avantages et inconvénients pour ne pas se laisser avoir par leur aspect « bluffant ». Le caractère prédictif, la véracité des informations générées (dont les sources ne sont pas vérifiables), la non émotivité et le reflet de systèmes discriminatoires de ces IA, entre autres, attestent de l’importance de ne pas accepter passivement leur arrivée. Il est nécessaire de contrôler et de mettre en place des cadres pour guider les individus, et notamment les étudiants, dans leurs usages.

Les étudiants pourront très probablement y trouver un intérêt pour progresser dans des compétences qu’ils n’ont pas, développer leurs capacités rédactionnelles ou bien stimuler leur créativité. Apprendre à formuler des requêtes (prompts), connaître les risques de désinformation, ou encore analyser les images générées semblent être des compétences à développer à court et moyen long terme.

Mai 2024

Jessica Lessin « Media Companies Are Making a HugeMistake With AI », ICT Journal, 24 mai 2024

- Les sociétés de presse cherchent de plus en plus à établir des accords avec des entreprises technologiques afin de surmonter les innovations numériques successives. Or, la presse semble se sacrifier au détriment d’entreprises numériques, leur assurant un élargissement de l’audience en concluant des accords avec eux. Des éditeurs comme News Corp l’ont fait avec Apple et l’iPad, en investissant des sommes énormes dans un contenu flashy qui ne leur a pas rapporté d’argent mais a aidé Apple à vendre plus de matériel. Aussi, ils ont reçu des paiements de Google pour proposer leur journalisme gratuitement via recherche, pour constater que cela a érodé leurs activités d’abonnement. Enfin, ils ont tenté de s’aligner pour produire des émissions vidéo originales pour Facebook et reformater leurs articles pour bien fonctionner dans sa nouvelle application. Mais la société de médias sociaux a annulé les émissions et l’application. De nombreuses sociétés de presse ont donc fait faillite. Pourtant, ces mêmes sociétés semblent faire la même erreur avec les IA.

- La confiance donnée en ces sociétés derrière les IA par les maisons de presse ont engendré des problèmes de vol et des poursuites judiciaires finissant en accords commerciaux pour les absoudre du vol. Ces offres reviennent à un règlement sans litige.

- Les maisons de presse possèdent leur propre crédibilité durement gagnée pour un peu d’argent auprès des entreprises qui les sous-évaluent simultanément et construisent des produits clairement destinés à les remplacer.

- OpenAI offre à d’autres éditeurs entre 1 et 5 millions de dollars par an pour obtenir une licence sur leur contenu.

- OpenAI et d’autres se disent intéressés par la création de nouveaux modèles de distribution et de crédit des informations, et de nombreux responsables de l’information que je respecte les croient. Mais il est difficile d’imaginer comment un produit d’IA construit par une entreprise technologique pourrait créer une nouvelle distribution et des revenus significatifs pour l’information.

- Les entreprises IA visent à donner l’information plus rapidement car qui voudrait lire un tas d’articles d’actualité alors que l’IA pourrait en faire en résumé en bas de page en créditant l’auteur ?

- Désormais, le journalisme télévisé est soumis aux caprices des plus grands conglomérats médiatiques, qui cherchent désormais à découper en dés et vendre leurs empires au plus haut de leur valeur marchande. Des médias risquent de fermer, tandis que d’autres finiront entre les mains d’individus puissants qui les utiliseront pour leurs propres programmes.

- Les éditeurs doivent être patients et s’abstenir de céder sous licence leur contenu pour des centimes relatifs. Ils devraient protéger la valeur de leur travail et de leurs archives. Ils devraient avoir l’intégrité de dire non.

L’article étudie les relations entre la presse et les technologies numériques. De nombreux médias, en tentant de s’aligner sur IA, semblent en réalité participer à leurs propres fins, en laissant ces entreprises de la tech utiliser leur labeur pour servir leurs propres intérêts.

Charlie Warzel «

Charlie Warzel », The Atlantic, 21 mai 2024

- L’article parle du débat sur la voix d’OpenIA ressemblant à celle de Scarlett Johansson. Sam Altman, fondateur d’Open AI aurait demandé à l’actrice de prêter les droits sur sa voix. Celle-ci ayant refusé, la voix nommée Sky développé ressemblerait tout de même à celle de Johansson.

- Altman a posté un tweet quelques jours sur Sky et le film « Her » de Spike Jonze dans lequel l’actrice prête sa voix à une IA, assumant ainsi les similitudes.

- Cet exemple illustre le manque de préoccupations éthiques des géants de la tech qui opèrent en toute impunité en récoltant des données non consenties pour développer leurs technologies. Malgré des débats, discussions, l’exemple de Scarlett Johansson rappelle l’inévitable destin de l’IA: cela se produit, que cela vous plaise ou non.

- Ainsi, ce phénomène se prolonge avec l’explosion fulgurante des IAA, pouvant diminuer considérablement la part humaine dans chaque activité.

- Le développement de l’IA est avant tout géopolitique : c’est une course contre les autocraties. Dans un monde idéal, l’IA devrait être un produit des nations. Mais dans ce monde, Altman semble considérer son entreprise comme son propre État-nation.

- Selon lui, il y a un échec de l’évolution culturelle avec ces IA. Malheureusement, les avertissements des chercheurs et artistes (sur les droits d’auteur notamment) ne semblent pas avoir suffi à faire réagir les décideurs politiques et journalistes.

- Cette logique froide et paternaliste démontre le rationnalisme des géants derrière cette technologie. On peut lutter contre mais son arrêt définitif semble impossible. C’est une technologie qui nécessite un état d’esprit de destin manifeste, de domination et de conquête.

L’article traite de la froideur d’OpenIA, rejetant les notions de consentement par la création d’une IA vocal ressemblant à la voix de l’actrice Scarlett Johansson. Cette dernière ayant refusé à plusieurs reprises, les géants de la tech semblent prêts à tout pour imposer leurs technologies, quitte à enfreindre toute les lois concernant les données personnelles et la vie privée.

Tyler Austin Harper « The big AI risk not enough people are seeing », The Atlantic, 21 mai 2024

- L’usage d’IA dans les applications de rencontres aiderait les usagers.ères à mieux se connaître et à mieux comprendre leurs attentes en amour, selon la présidente exécutive de l’application de rencontres Bumble. En se confiant à l’IA, on participerait au développement d’une IA personnalisée, pouvant donner des conseils en fonction de notre personnalité.

- Si ce type d’IA venait à se démocratiser, le futur des relations humaines passerait automatiquement par un filtre algorithmique. Flirter et socialiser seraient contrôlés par les IA.

- Le philosophe Ivan Lillich en 1977 face à la dominance des bureaucraties métastatiques déclarait que nous entrions dans « l’ère des professions invalidantes ». Selon lui, la modernité se caractérise par la standardisation et la professionnalisation de la vie quotidienne. Ce phénomène s’illustre par l’apparition d’ « experts techniques », formés dans des institutions réputées d’élite, qui ont pris en charge des tâches autrefois accomplies par des non-spécialistes (comme soigner des blessés de guerre ou s’occuper d’enfants). Par exemple, le médecin agréé a remplacé le guérisseur local ou les pédopsychologues et leurs recherches « de pointe » ont remplacé les parents et leurs instincts. La juridiction de l’homme du commun a été remplacée par ces experts dits certifiés. Dans certains domaines, comme la médecine, ces représentants accrédités ont favorisé des avancées positives en effectuant des calculs visant à protéger les êtres humains. Cependant, dans d’autres secteurs, leur rôle reste sujet à débat.

- Ainsi, ce phénomène se prolonge avec l’explosion fulgurante des IA, pouvant diminuer considérablement la part humaine dans chaque activité.

matchmaking numérique est tendance, et les développeurs de services de rencontres en ligne sont tous conscients du trouble que les algorithmes instaurent, en dirigeant nos romances. Nous devenons dépendants des décisions algorithmiques : nous perdons la surveillance de nos propres processus de pensée et même de nos relations sociales. La rhétorique de l’IAempowerment sert de façade pour les géants de la Silicon Valley qui cultivent délibérément la dépendance du public à leurs plateformes. La restriction de l’indépendance humaine n’est donc pas un accident, mais bien une caractéristique intentionnelle de la ruée vers l’or de l’IA. - Selon lui, il y a un échec de l’évolution culturelle avec ces IA. Malheureusement, les avertissements des chercheurs et artistes (sur les droits d’auteur notamment) ne semblent pas avoir suffi à faire réagir les décideurs politiques et journalistes.

- Faire la distinction entre les IA autonomisant légitimement les activités humaines et celles arrachant aux humains, les activités essentielles au contrôle des êtres humains. Or cette position incarne l’idée d’une « nature humaine » universelle, expression désormais répandue comme échos de droite. Elle va donc à l’encontre de la diversité et de l’égalité des différentes traditions culturelles humaines, défendues par la gauche. Si la nature humaine n’existe pas et s’il n’y a pas de noyau ensemble d’activités, de désirs ou de traits humains fondamentaux, sur quelle base pouvons-nous argumenter contre l’externalisation de ces efforts autrefois humains vers des machines ?

- Une solution pour sortir de cette impasse serait l’approche capacitaire de l’épanouissement humain, développée par la philosophe Martha Nussbaum et d’autres. Selon cette approche, une société juste est celle où les individus ne sont pas seulement théoriquement libres de s’engager dans des activités humaines essentielles, mais sont réellement capables de le faire (par exemple, être capables d’imaginer, de penser et de raisonner, ainsi que de participer à diverses formes d’interaction familiale et sociale).

- Ainsi, il faut lutter contre la culture de l’incompétence et l’incapacité sous couvert d’autonomisation.lle et à d’autres fins ».Cela aiderait à la fois aux usagers et aux entreprises de comprendre et d’avoir accès au contenu des données.

- Ainsi, déployer des modèles dans la sphère publique sans contrôle est également une négligence. Les systèmes d’intelligence artificielle peuvent être une boîte noire, mais les décisions humaines qui vont dans leur construction et leur déploiement sont claires.

- Selon l’auteur de l’article, sans un minimum de consensus sur ce que sont ces capacités humaines fondamentales – quelles activités relèvent de notre domaine en tant qu’espèce et ne doivent pas être usurpées par des machines – il devient difficile de comprendre pourquoi certaines applications de l’intelligence artificielle nous enthousiasment, tandis que d’autres nous mettent mal à l’aise. L’inquiétude vient principalement du fait que les IA n’étendent pas nos capacités de réflexion par les IA mais les sous-traitent Analyser des idées et les communiquer, établir des connexions spontanées avec les autres, etc sont des compétences humaines qui risquent probablement de diminuer.

L’usage de l’IA dans les applications de rencontres, comme Bumble, pourrait aider les utilisateurs à mieux se comprendre, mais risque de filtrer les relations humaines à travers des algorithmes, réduisant la spontanéité des interactions. Ivan Illich critiquait la professionnalisation excessive où des “experts techniques” remplacent les non-spécialistes dans diverses tâches, ce qui a mené à des avancées positives en médecine, mais suscite des débats dans d’autres secteurs. Cette tendance se poursuit avec l’IA, diminuant la part humaine dans de nombreuses activités. La rhétorique de l’IAempowerment masque l’objectif des géants de la Silicon Valley de rendre le public dépendant de leurs plateformes, restreignant l’indépendance humaine de façon délibérée. L’approche capacitaire de Martha Nussbaum propose une société où les individus sont réellement capables de s’engager dans des activités humaines fondamentales. Sans consensus sur ces capacités, il est difficile de comprendre l’enthousiasme ou l’inquiétude suscités par différentes applications de l’IA. L’IA risque de sous-traiter nos capacités réflexives et sociales, menaçant des compétences humaines essentielles.

Janvier 2024

Eryk Salvaggio « LAION-5B, Stable Diffusion 1.5, and the Original Sin of Generative AI », The Good Tech Policy.press, 2 janvier 2024

- L’article fait une analogie entre l’infrastructure Omelas, tirée de l’ouvrage de fiction d’Ursula K. Le Guin « The Ones Who Walk Away From Omelas », ville assurant une vie d’abondance grâce au progrès technologique et les IA génératives. Or, elles cachent toutes les deux une misère enfantine pour parvenir à cette technicité.

- Dans Omelas, un enfant vivant dans la douleur et la saleté serait nécessaire à la ville et des chercheurs ont récemment découvert que plus de 1000 URL utilisées pour Stable Diffusion (outil d’image IA) contiennent du contenu d’abus sexuels sur enfants. L’ensemble de données utilisé est LAION-5B, comprenant environ 2,3 milliards d’images.

- L’article explique que les images d’un enfant généré par l’IA sont assemblées à partir de milliers d’abstractions de véritables photographies d’enfants.La présence de pédopornographie dans ces données est préoccupante : des images générées peuvent utiliser des images d’abus sexuels sur enfant et faire également apparaître des images violentes. Il y a donc une forte négligence dans le traitement des données. Cette crise est en partie le résultat de la question de savoir avec qui les décideurs politiques discutent et définissent l’IA: trop souvent, ce sont les experts de l’industrie qui ont tout intérêt à dissuader l’attention du rôle des données de formation, et les faits de ce qui se trouve en son sein.

- Les données de LAION sont collectées sans supervision : certaines entreprises utilisent de la main d’œuvre sous-payée pour vérifier (Cf.Antonio A. CASILLI, En attendant les robots. Enquête sur le travail du clic, Paris, Seuil, 2019) les exposant ainsi à des contenus traumatisants.

- Le rapport de Stanford note que LAION n’a jamais été consulté par des experts de la sécurité des enfants. Au lieu de cela, LAION a été filtré avec CLIP, un système automatisé de détection de contenu.

- L’auteur après avoir fait sa propre analyse remarque que la même dynamique que l’utilisation d’images pédopornographiques est récurrente. On trouve de nombreuses images mêlant des catégories sans rapport comme des images de soldats nazis présentés sous forme héroïque. Il qualifie ces assemblages de « collages de traumatisme »

- Selon lui, il y a un échec de l’évolution culturelle avec ces IA. Malheureusement, les avertissements des chercheurs et artistes (sur les droits d’auteur notamment) ne semblent pas avoir suffi à faire réagir les décideurs politiques et journalistes.

- Les médias sont également à critiquer vantant les résultats de ces IA, sans se concentrer sur les questions de supervision humaine derrière et de biais. Il y a aussi un manque d’attention des médias et des politiques sur les chercheurs comme le Dr.Birhane dont les travaux de recherche explorent LAION-5B. On valorise les experts de l’industrie, détournant les conversations sur les droits des données et de la transparence.

- L’année 2023 a été marquée par des illusions d’intelligence générale artificielle, la promesse d’une sophistication qui émerge d’un concept abstrait d’« intelligence ». Cela amplifie le manque de transparence sur le fonctionnement de ces entreprises.

- Ne pas donner une confiance absolue en ces entreprises serait déjà un premier pas à faire. Ainsi, développer des modèles ouverts serait-il la solution? Or, en étant ouverts, toutes sortes de variations peuvent être construites, y compris des modèles spécifiquement conçus pour les deepfakes, le harcèlement ou la maltraitance des enfants. On revient au même problème. Le projet de loi The AI Foundation Model Transparency Act, semblent cependant montrer un compromis intéressant. Le projet de loi demanderait à la « Commission fédérale du commerce d’établir des normes pour la diffusion d’informations publiques sur les données et algorithmes de formation utilisés dans les modèles de base de l’intelligence artificielle et à d’autres fins ».Cela aiderait à la fois aux usagers et aux entreprises de comprendre et d’avoir accès au contenu des données.

- Ainsi, déployer des modèles dans la sphère publique sans contrôle est également une négligence. Les systèmes d’intelligence artificielle peuvent être une boîte noire, mais les décisions humaines qui vont dans leur construction et leur déploiement sont claires.

- Il y a aussi une reconsidération à faire des données, marques de nos vies vécues en ligne. Les effacer n’est pas la solution : il s’agirait de les encadrer et de les protéger et pouvoir prendre des décisions sur les archives qui façonnent les résultats d’IA.

- L’auteur conclut par dire que les infrastructures technologiques sont accumulées, plutôt que conçues. Il faudrait prendre le temps pour des soins et des dépendances réfléchis dans nos vies numériques. Sinon, nous risquons de construire un avenir dans lequel la douleur des autres est ancrée dans la négligence. Nous risquons de construire l’IA comme Omelas a été construite.

LAION-5B, une base de données d’images IA, renferme des contenus d’abus sexuels sur enfants. La gestion négligée de ces données est pointée du doigt, accentuée par l’absence de supervision dans leur collecte. Les failles dans la sélection des contenus et le manque de consultation d’experts soulignent une problématique de gouvernance de l’IA, exacerbée par le manque de transparence des entreprises. Les médias glorifient souvent les résultats de ces IA sans aborder les questions de supervision et de biais. Les propositions comme le projet de loi The AI Foundation Model Transparency Act visent à instaurer une transparence dans l’utilisation des données et des algorithmes, offrant ainsi une meilleure compréhension et accessibilité à leur contenu. Toutefois, déployer des modèles IA sans contrôle expose à des risques, nécessitant une régulation pour encadrer et protéger les données qui alimentent ces systèmes. En somme, l’auteur met en garde contre la construction négligente des infrastructures technologiques, appelant à une réflexion approfondie sur nos vies numériques pour éviter un avenir où la souffrance des autres serait enracinée dans la négligence, semblable à la construction d’Omelas.

Juillet 2023

Rodolphe Koller « Les développeurs d’IA craignent de ne plus disposer de données humaines via le crowdsourcing », ICT Journal, 7 juillet 2023

- Les entreprises utilisant les IA s’appuient sur des données gratuites en ligne ou sur des entreprises dans des pays à bas coût comme OpenAI, exploitant des étiqueteurs kenyans pour gérer les contenus les plus durs.

- Les humains fournissent « l’oxygène aux algorithmes » mais l’abondance d’images génératives renverse ce schéma habituel : les IA s’alimentant d’images IA.

IA à partir de contenus d’autres IA engendre donc une baisse de la part humaine derrière ces plateformes. - Analogie faite avec le Turc Mécanique et la plateforme de crowdsourcing d’amazon Mechanical Turk, un prétendu automate joueur d’échecs créé au XVIIIème siècle, qui était un humain en réalité. Ainsi, on pense recourir à des machines avec ce service alors que ce sont des humains en réalité derrière mais qui utilisent potentiellement des machines pour gagner en productivité : «intelligence artificielle artificielle artificielle».

- Des chercheurs de l’EPFL ont mené une étude sur le nombre de travailleurs de Mechanical Turk utilisant ChatGPT pour rédiger leur résumé : 1⁄3 auraient utilisé ChatGPT. Les données humaines seront de plus en plus compliquées à extraire.

Les IA semblent s’entraîner de plus en plus avec des données générées par les IA elles-mêmes. En cause, la profusion de données IA en ligne et les étiqueteurs humains, par souci de productivité et de gain de temps, qui utilisent désormais les IA pour réaliser leurs tâches.

Juin 2023

Josh Dzieza « AI Is a Lot of Work », The Verge, 20 juin 2023

- L’article parle des modérateurs et entraîneurs des IA, sous-payés et issus majoritairement de pays en développement.

- Un de ces travailleurs, renommé Joe, a été interrogé dans l’article. Joe a dirigé un camp d’entraînement d’annotation à Nairobi pour une nouvelle entreprise et les demandes de travail ont été nombreuses. D’abord formés dans des camps, les étudiants travaillent ensuite depuis leur chambre et sont tenus par une clause de confidentialité. Ils ont interdiction de dévoiler ce qu’ils font ou pour qui ils travaillent. Les tâches consistent à étiqueter et entraîner les IA à reconnaître des éléments (vêtements vus dans les selfies miroir, de regarder à travers les yeux des robots aspirateurs pour déterminer dans quelles pièces ils se trouvaient etc). Mais la plupart abandonnent la formation car c’est un travail répétitif et ennuyeux.

- La plupart des individus ne savent pas non plus pour qui il travaille réellement. Par exemple, Joe, a appris que l’entreprise pour laquelle il travaille, Retomasks, est une filiale de Scale AI, fournisseur de données de la Silicon Valley de plusieurs milliards de dollars comptant OpenAI et l’armée américaine parmi ses clients.

- La fixation de la valeur de chaque vie humaine est un sujet à débattre. Selon Jean-François Bonnefon, de la même manière que des individus sont priorisés lors des campagnes de vaccination, il faudrait plus travailler sur « les préférences en matière de distribution des probabilités de vivre».

- Les IA actuelles existent grâce à un travail fastidieux et répétitif fait depuis des années. En 2007, le chercheur en IA Fei-Fei Li disait déjà que pour améliorer les IA, il faudrait les entraîner sur des millions d’images étiquetées. Pour entraîner ces IA, Li a trouvé des milliers de travailleurs sur Mechanical Turk (plateforme de crowdsourcing d’Amazon pour trouver de la main-d’œuvre pas chère). Le travail d’annotation fait par la suite a donc permis de faire évoluer considérablement l’apprentissage automatique. Les ingénieurs pensent souvent que l’annotation n’est qu’une étape passagère et qu’une fois les images étiquetées récoltées, cette étape peut se terminer. Or, l’annotation demande un travail continu : les situations sont multiples, il faut constamment vérifier les images et donc toujours plus de main-d’œuvre.L’entreprise de Joe en est l’exemple.

- : cela peut passer par la détection d’émotions des visages sur TikTok ou par de l’examination de nos cartes de crédit, pour nous suggérer des articles similaires à nos tendances de consommation. Tout est catégorisé, nos émotions aussi.

- L’intelligence humaine est la base de l’intelligence artificielle : les emplois humains derrière sont indispensables.

- Les entreprises fournisseuses de données ont différentes formes : sociétés privées d’externalisation avec des bureaux de type centre d’appel(Kenya et au Népal), sites de “crowdworking” comme Mechanical Turk et Clickworker ou des services comme Scale AI où tout le monde peut s’inscrire, sous réserve de réussir des examens de qualification et des cours de formation et où un suivi des performances est instauré. Scale AI, par exemple, a été fondée en 2016 par Alexandr Wang, alors âgé de 19 ans, était évaluée en 2021 à 7,3 milliards de dollars.

- Le journaliste parle de l’épuisement face aux mises à jour constantes des instructions d’étiquetage. Les règles changent constamment. La difficulté est de devoir simplifier des réalités complexes en quelque chose de compréhensible pour des machines non intelligentes. Catégoriser le monde avec une cohérence parfaite est l’enjeu des ingénieurs. Ils inventent donc des catégories que les humains n’utiliseraient jamais car les machines n’ont pas de compréhension du fonctionnement de notre monde. Par exemple, un humain saura que le reflet d’une chemise dans un miroir n’est pas la vraie chemise; la machine non. Pour l’IA tout est pixel. Les annotateurs doivent donc penser comme des robots, penser de manière absurde le monde.

- Les salaires évoluent en fonction de la rapidité et du nombre de tâches effectuées par le salarié. Cet emploi est suffisamment stable pour être un emploi à temps plein pendant de longues périodes, mais trop imprévisibles pour s’y fier. À tout moment, le salarié peut ne pas avoir des tâches pendant des mois. Cette instabilité est liée au développement des IA, vacillant. Face à ça, des communautés d’entraides d’annotateurs se sont créées sur les réseaux sociaux pour permettre le partage de bonne tâche, lorsqu’elles tombent.

- Un des annotateurs parle de son envie d’aider à créer un avenir post-travail entièrement automatisé, malgré l’invisibilisation de ce travail.

- D’autres travailleurs des IA sont mieux payés, comme ceux entraînant les chatbots. Le travail consiste à parler toute la journée au chatbot et le salaire est d’environ 14$ de l’heure, plus des primes s’il y a une forte productivité. « c’est nettement mieux que d’être payé 10 $ de l’heure au magasin Dollar General local », déclare une de ces salariées qui nous dit aussi que ce travail est plus stimulant intellectuellement. Elle peut parler de sciences-fiction, de paradoxes mathématiques et autres. Les réponses du bot peuvent être très drôles mais limitées, ce qui est épuisant pour les salariés qui doivent constamment échanger et questionner le bot.

- Le chatbot fournit deux réponses et le salarié doit choisir la meilleure réponse, créant ce qu’on appelle « données de rétroaction humaine » : les retours de l’IA imitent les conversations humaines de manière impressionnante car ils ont été formés sur des la culture humaine.

- Les critères d’évaluation varient entre honnêteté, serviabilité ou préférences personnelles : les données se basent donc sur des goûts humains. Le fait est qu’ils créent des données sur le goût humain, et une fois qu’il y en a assez, les ingénieurs forment un deuxième modèle pour imiter leurs préférences à grande échelle, en automatisant le processus de classement et en formant leur IA à agir d’une manière que les humains approuvent. Ainsi le bot est humain, même dans sa manière d’expliquer la conscience de soi.

- Ainsi, ChatGPT, par exemple, semble si humain parce qu’il a été formé par une IA qui imitait des humains qui évaluent une IA qui imitait des humains qui prétendaient être une meilleure version d’une IA formée à l’écriture humaine.

- Or cette technique d’ « apprentissage par renforcement à partir de la rétroaction humaine » (RLHF) est si efficace qu’il est nécessaire de faire une pause pour observer ses failles. Par exemple, ces IA ne peuvent pas vérifier leurs réponses à partir de la logique ou en s’appuyant sur des sources externes fiables et donc, assurer des réponses vraies. Les Les étiqueteurs peuvent marquer des textes vrais alors qu’ils ne le sont pas, et lorsqu’il est vrai, il n’est pas sûr que le modèle en apprenne les bons modèles. Le travail d’étiquetage demande donc de l’attention et de la cohérence : il faut éviter des commentaires bâclés. Geoffrey Irving, chercheur chez DeepMind, nous dit que des réunions d’annotations hebdomadaires ont lieu pour discuter avec des experts en éthique, des cas compliqués et ambigus.

- À mesure que les IA s’améliorent, il est plus compliqué de repérer les mauvaises sorties : c’est ce qu’on appelle la « surveillance évolutive ». Ainsi, les travailleurs vont devoir être de plus en plus spécialisés pour mieux repérer les spécificités d’un domaine précis dans les sorties IA. À ce propos, Chen, fondateur de Surge (start-up spécialisée en biotechnologie et en IA médicale), dit : « Le paysage de l’annotation doit passer de cet état d’esprit de faible qualité et de faible compétence à quelque chose de beaucoup plus riche et qui capture l’éventail des compétences humaines, de la créativité et des valeurs que nous voulons que les systèmes d’IA possèdent. »

- Une pression financière sur l’automatisation de l’étiquetage augmente, l’enjeu étant de réduire considérablement la quantité d’annotations humaines. Les besoins en données vont diminuer selon Sam Altman, pdf d’OpenAI, à mesure que l’IA va s’améliorer. Or Chen est septique sur ce point : l’IA n’atteindra pas un point où la rétroaction humaine n’est plus nécessaire. La voie à suivre serait d’impliquer des systèmes d’IA aidant les humains à superviser d’autres IA. Une autre possibilité est que des IA débattent entre elles et qu’un humain rend le verdict final sur lequel est correct.

- Le travail d’annotation est cependant mobile : les entreprises se déplacent d’un pays à un autre car c’est un travail qui change constamment, en comparaison avec la téléphonie par exemple. Des nouveaux besoins émergent pour de nouveaux types de données. C’est une chaîne de montage, mais qui peut être reconfigurée à l’infini et instantanément, se déplaçant là où il y a la bonne combinaison de compétences, de bande passante et de salaires.

- La problématique dans la finalité du traitement des données est l’importance de vouloir finir toutes les données plutôt que de les traiter de manière cohérente.

- Beaucoup de travailleurs utilisent des VPN ou louent des serveurs proxy pour cacher leurs emplacements. Ainsi ils peuvent avoir plusieurs comptes dans différents pays afin de travailler dans les pays où le salaire est le plus élevé et ainsi cumuler les emplois.

Cet article collaboratif, rédigé par the New York Magazine et the Verge, examine les conditions de travail des annotateurs, chargés d’étiqueter les données d’entrainements des IA.

El Mahdi El Mhamdi, « Que se cache t-il derrière l’IA ? Un ancien chercheur de Google répond à vos questions », T’as Capté, 13 juin 2023

- La définition de l’intelligence selon El Mhamdi est la capacité à traiter de l’information pour résoudre des problèmes complexes, selon des objectifs précis. Elle peut s’élargir aussi aux organisations humaines qui sont des systèmes traitant et émettent de l’information et qui suivent des objectifs. La partie artificielle est liée à l’utilisation de machines.

- Différence fondamentale entre intelligence humaine et artificielle est dans l’objectif : l’IA a un objectif précis, défini par des humains. Or, l’intelligence humaine suit des objectifs multiformes : c’est un mélange de phénomènes humains (institutions, cultures, normes sociales…). Mais ces deux intelligences se rassemblent par le traitement de l’information.

- Ce qui fait la force de l’intelligence humaine c’est tous les gardes-fous que l’évolution sociale a mise en place pour rendre cette intelligence fiable. Challenge actuel avec IA est donc de reproduire ces mécanismes pour arriver à l’intelligence humaine.

- 2 paradigmes des IA : la programmation (règles à suivre) et l’apprentissage (agir et déduire des règles pour les écrire ensuite).

- IA fonctionne de la manière suivante : les IA sont composés de réseaux de neurones qui essayent de mimer la biologie. Ce sont des petites unités de calculs liées par des synapses avec des coefficients. Imaginons que nous avons en entrée un texte et à la sortie une image : entre ces deux éléments il y a une multitude de neurones artificielles qui vont traiter des segments de l’image. Le défi pour les IA est de comprendre quel est le bon paramètre à choisir et mettre sur chaque connexion. On va donc donner à ces réseaux beaucoup d’images et de noms qui vont avec (ce que nous faisons gratuitement sur les réseaux sociaux en taguant les gens), et c’est un algorithme qui va corriger les erreurs commises à la sortie pour réajuster les paramètres.

- Ces réseaux de neurones sont connus depuis les années 80 avec les théorèmes d’universalité. La puissance de calculs actuelle permet donc de concrétiser ces théories, 40 ans après.

- Exemple de Cambridge Analytica qui a été un fichage massif pour influencer l’électorat. Les équipes politiques ont créé des contenus personnalisés à montrer aux individus analysés comme les plus influençables.

- On parle de règles futures à établir avec les IA or, les grandes entreprises derrière ces IA violent déjà des lois actuelles. Les États se voient donc désarmés.

- Il ne faut pas que le techno progressisme nous rendent naïfs : le PDG de Netflix dit que « Notre premier compétiteur c’est le sommeil ». Les algorithmes, vu qu’ils ne sont pas régulés et qu’ils violent des droits et lois, peuvent donc être optimisés pour nous empêcher de dormir.

- Parler d’IA éthiques n’a pas de sens : cette notion introduite par les entreprises créent une forme d’approche faussement militante avec les IA. Il faudrait plutôt se réapproprier ces IA et ne pas accepter de les appeler IA fiables ou éthiques.

- Turing disait déjà dans les années 50 que si une machine est intelligente alors elle ne pourra pas être fiable. Il y aura toujours une contradiction entre performance et fiabilité.

- Le nombre de paramètres est une cause de non fiabilité des IA: cela les rend plus vulnérables car elles emmagasinent plus d’informations et sont donc plus susceptibles de fournir de fausses données. Aussi, plus l’IA a de données, plus les données personnelles des utilisateurs sont violées.

- Des lois sur la collecte massive des données commencent à voir le jour comme le Cyber Resilience Act digital-strategy.ec.europa.eu/en/library/cyber-resilience-act

- Face à l’explosion des technologies, connaître les fondamentaux est essentiel, plutôt que la course aux gadgets.

- Autre fantasme est le couplage IA sous forme de logiciels avec des robots mécaniques et physiques qui vont exécuter ces commandes. Ce fantasme est à la fois loin et actuel avec notamment les drones tueurs. On assiste à une prolifération de la cyberguerre (armes autonomes, cyberattaques…).

- La dystopie qui peut arriver est celle du chaos informationnel (individus qui n’arrivent plus à distinguer le vrai du faux, discours haineux populaire…). On a une déstabilisation informationnelle.

- Informatique moderne (années 30) est dans la continuité de la philosophie. Il y a eu vers la fin du XIXe siècle, la crise des fondements de la logique car on se rendaient compte que ces logiques étaient contradictoires (Cf. « Le paradoxe du barbier »). Turing apporte une preuve que tout ne peut pas être su, en prouvant ce qui ne peut pas être su. Il a alors mis un cadre formel à ce qui peut être su (machine universelle de Turing). C’est à cause de cette universalité qu’aujourd’hui, nous ne sommes plus surpris d’avoir des machines qui peuvent faire plusieurs choses à la fois. Cette universalité a donné l’informatique de la programmation. Dans l’article « Can machine think ? » Turing voit les limites de la programmation. En faisant des analogies avec le cerveau humain, il se rend compte que cela sera donc impossible de programmer une machine aussi complexe que le cerveau humain. Il faudra donc apprendre et faire de l’induction selon Turing.

- Il est important de distinguer la déduction et l’induction. Les mathématiques sont la science de la déduction (on apprend des théorèmes et on les applique en fonction des situations), et les sciences naturelles de l’induction (on observe les espèces vivantes et on induit des lois et théories à partir de l’observation). Le passage de la déduction à l’induction a été prévu dès les années 50 par Turing et est équivalent au passage du créationnisme à l’évolutionnisme en biologie. Il faut aussi se rappeler que la maîtrise de la logique est récente dans l’évolution humaine. En armant les ordinateurs des outils de la déduction (logique), on a eu les systèmes d’exploitation, Internet etc. Aujourd’hui le défi est de faire de l’informatique de l’induction, chose que l’on ne maîtrise pas encore assez et qui amène ainsi à tous les problèmes que nous connaissons avec les IA.

El Mahdi El Mhammdi, enseignant-chercheur et anciennement scientifique senior chez Google, explique le fonctionnement des IA et les problématiques avec ces systèmes. La vidéo commence par des explications pédagogiques, destinées aux néophytes, avant d’arriver à des analyses plus historiques et techniques de ces algorithmes.

Lev Manovich, « Towards ‘General Artistic Intelligence? », Arte, 1er juin 2023

- Question de l’IA générale artistique : quand verrons-nous l’apparition d’une IA capable d’effectuer n’importe quelle tâche humaine créative ?

- Analyse des images générées par les IA qui sont avant tout esthétiques : leurs compositions semblent parfaitement équilibrées, les couleurs diversifiées et les formes rythmées.

- L’IA est professionnelle mais non créative selon Lev Manovich, car elle est techniquement plus développée que de nombreux travaux d’étudiants. Un portfolio fait d’images générées par une IA, avec un texte créé par ChatGPT pourrait faire entrer n’importe quel étudiant dans un programme d’art selon lui.

- Or, les réseaux de neurones sont limités par leur non compréhension de ce qu’ils génèrent. Ils n’ont pas de capacité d’évaluation sur ce qui est intéressant ou banal. Ils ne peuvent pas aller puiser dans des ressources rares, car ils se basent sur des ressources dominantes et donc, génèrent des choses conventionnelles.

- Comparaison par Manovich des images IA avec le classicisme par l’idéalisation et la « perfection » de ces images. Il y a une dramaturgie, poussée à son paroxysme, dans les images IA.

- Kitsch et l’IA : le kitsch qui est apparu dans les marchés de l’art dans Munich entre 1860 et 1870, décrit les images peu coûteuses et populaires. Le kitsch permet d’identifier rapidement et sans effort un sujet, par un aspect mélodramatique et stéréotypé. Les images AI semblent s’inscrire dans cette veine par une facilité de reconnaissance du sujet, dont l’esthétique est souvent poussé jusqu’à créer un effet dramatique donc exagérément naïf.

- L’art de la copie par les IA : il y aurait quatre types de copies. D’abord, celle où vous pouvez répéter le processus indéfiniment avec la même invite de texte et en espérant voir des améliorations. Ensuite, copier les invites de textes d’autres personnes, dont les résultats vous intéressent. Aussi, voir comme dans le mode par défaut de Midjourney les invites et les images IA en temps réel des autres utilisateurs. Enfin, les images IA sont par défaut de la copie car les invites font majoritairement référence à la pop culture.

- Différence entre cet « art de la copie » des IA et les millions d’images d’artistes amateurs créant des copies de personnages fictifs depuis ArtStation ou DeviantArt est dans le mécanisme de copie. Nous pouvons maintenant copier des textes pour générer des images, avant cela passait par du calque et moduler ces invites de textes pour modifier le contexte en quelques secondes. Cependant, la copie a toujours été présente dans la culture humaine : il serait donc insensé de rejeter la culture visuelle vernaculaire de l’IA comme non authentique. En effet, les copies et variations ont toujours existé comme par exemple, la famille de Bruegel qui a produit environ « 127 paysages d’hiver avec patineurs et pièges à oiseaux » en 1565. Selon l’économiste politique Krzysztof Pelc, “la moitié de toutes les œuvres d’art commandées au XVIe siècle étaient des copies d’originaux.

- Rejeter la copie c’est rejeter son impact dans l’histoire : les imageries IA créée par des amateurs perpétuent ainsi cet héritage de la copie, où l’imitation constante et les petites modifications ont leurs importances.

- Lev Manochich conclut en revenant sur son questionnement du début : assisterons-nous à la une IA artistique générale ? Il serait plus intéressant de voir une IA proposant des idées aux artistes par une analyse d’œuvres plutôt qu’une IA générant des images. Cette IA servirait à visualiser l’évolution de motifs, sujets et formes dans des oeuvres au fil du temps et donc initier des nouvelles directions et la recommandation d’outils adaptés en fonction de la finalité voulue. L’idée serait de développer des IA invitant plus au dialogue.

Lev Manovich traite de l’état actuel des images générées par les IA et de leurs aspects bien trop souvent dramaturgiques et donc kitsch. Les mécanismes de copie d’invites de textes couplés à une analyse d’images populaires par les IA peuvent expliquer en partie cette profusion d’images stéréotypées et mélodramatiques. Mais contester la copie reviendrait à rejeter l’importance de la copie dans l’histoire humaine, qui a toujours eu un rôle capital dans l’évolution des représentations. Il serait, cependant, plus souhaitable de voir apparaître des IA dialoguant avec les artistes, en leur initiant des idées par une analyse d’œuvres d’art. Cela permettrait de stimuler l’imagination des humains, plutôt que de fournir des images en quelques secondes, réduisant ainsi les capacités créatrices.

Mai 2023

Alexandre Lacroix « Les voitures sauront-elles bien se conduire ? », philosophie magazine, Hors série n°57 : Intelligence artificielle : le mythe du XXIème siècle, mai 2023

- « Dilemme du tramway » : expérience pour voir le choix d’un individu face à une situation impliquant de tuer quelqu’un. Qui tuerait-on ? Ce dilemme sera de plus en plus au cœur des débats avec le développement des voitures autonomes car on devra expliciter aux IA quelle décision prendre selon la situation. Avant, cette question se posait peu car l’humain n’est pas programmé et donc, agit en circonstance par de la spontanéité, chose que l’IA est incapable de faire.

- Première étape est de demander aux gens ce qu’ils décideraient dans différentes situations en observant la probabilité d’un choix consensuel (Cf. test du Moral Machine : série de treize questions sur quelle décision prendre en voiture dans des situations d’accidents mortels : https://www.moralmachine.net/hl/fr). Le test du Moral Machine lancé en 2016 par Jean-François Bonnefon, directeur de recherche au CNRS et des chercheurs du MIT, a démontré que les réponses Nord (Etats-Unis et Europe sauf France), Est (Asie) et Sud (Amérique du Sud et France) étaient assez similaires mais avec des poids respectifs différents selon les pays en cas de conflit. Mais attention à ne pas penser naïvement que ces différences sont dues uniquement à la religion : les origines des préférences sont multifactorielles avant tout. La question de sauver sa propre vie que celle d’un inconnu est centrale dans ce dilemme : sommes-nous plus égoïstes qu’utilitaristes ?

- Le choix du marché déterminera aussi la réussite de ces voitures autonomes : les gens achèteront-ils des voitures dont les prises de décision ne leur conviennent pas ? Les constructeurs ne seront donc plus les seuls décideurs des nouveaux modèles. Il y aussi deux types de constructeurs de voitures autonomes, ceux traditionnels (Audi, Hyundai…) et ceux venant de la tech (Google, Tesla…) dont les approches du risque sont différentes. Il y a cinq niveaux d’automatisation des véhicules : aide à la conduite (régulateur de vitesse), frein et direction autonome selon des contextes et au niveau cinq, il n’y a plus de volant. Les constructeurs arrivant directement au niveau cinq, prennent le risque de détruire leur marque si des accidents mortels et médiatisés se produisent. Or, les niveaux trois et quatre seraient plus inquiétants car l’humain et la machine alternent les prises de décisions : l’humain-machine serait potentiellement plus dangereux que la machine seule ?

- La fixation de la valeur de chaque vie humaine est un sujet à débattre. Selon Jean-François Bonnefon, de la même manière que des individus sont priorisés lors des campagnes de vaccination, il faudrait plus travailler sur « les préférences en matière de distribution des probabilités de vivre ».

- Peut-on justifier moralement un acte qui a deux conséquences, une négative et une positive ? C’est ce que « la doctrine a double effet » énoncé par Thomas d’Aquin dans la Somme théologique (1266-1273) questionne : selon lui, oui mais seulement si la solution positive précède la négative. Penser aux vies qu’on sauve avant de penser aux morts en somme. Un IA qui distribue des probabilités de vivre serait donc plus acceptable qu’un IA qui tue.

Cette étude sur l’éthique des voitures autonomes propose plusieurs pistes de réflexion sur la fixation de la valeur d’une vie humaine dans des accidents mortels. Comment doit-on développer des IA, devant prioriser des vies humaines ? Sur quels critères doit-on se baser?

« ChatGPT est-il dangereux ? », Arte, 27 mai 2023

- Un journaliste du monde a demandé à ChatGPT d’expliquer pourquoi Midjourney a du mal à représenter les mains. l’IA répond que la forme, la structure complexe et la diversité de mouvements des mains (¼ des os du corps sont dans les mains) rendent sa représentation complexe.

- Les IA générant des images fonctionnent à base de pixels. Elle doivent les agencer de manière cohérente pour rendre l’image compréhensible pour les humains. Les chercheurs utilisent la « diffusion » pour entraîner les IA en intégrant du bruit pour que l’image soit dégradée : les IA apprennent ainsi à les reconstituer.

- Des bases de données immenses sont analysées par les IA pendant des milliers d’heures afin de trouver des récurrences dans l’agencement des pixels et des combinaisons. Cela permet aux IA de saisir la multitude de variables d’une image : des observations qui vont au-delà de l’analyse par pixels et qui composent ce qu’on nomme l’« espace latent » de l’image (texture, lumière, etc.).

- Une fois le lien texte-image fait, les chercheurs demandent de faire marche arrière en demandant à l’IA d’utiliser la diffusion. Le programme génère des combinaisons inédites en s’inspirant de la manière dont les pixels s’agencent statistiquement dans leurs bases de données. La faille se trouve ici : pour l’IA les mains ne sont qu’une combinaison de pixels 2D, collée à une autre combinaison. L’IA ne comprend donc pas le fonctionnement d’une main par exemple. La forme des mains est rarement décrite dans les prompts et l’IA doit improviser.

- Une mise à jour de Midjourney a été annoncée en mars 2023 : les algorithmes ont davantage été entraînés sur les mains. Une meilleure compréhension spatiale de la main permettrait de générer des images de plus en plus cohérentes avec le réel.

Cette vidéo explique en 10min, le fonctionnement des IA générateur d’images, comme Midjourney, pour expliquer pourquoi certains éléments, comme les mains, restent difficiles à composer pour ces algorithmes.

Meghan O’Gieblyn « Does AI Have a Subconscious? », Wired, 23 mai 2023

- Meghan O’Gieblyn introduit l’article en parlant d’un essai dans lequel l’auteur affirmait qu’une conscience artificielle humaine n’existerait que dès lors qu’elle pourrait rêver.

- Ces systèmes sont éloignés des comportements humains car ils n’ont pas d’instinct, ne peuvent pas divaguer, ni rêver et n’ont pas de souvenirs. Les machines ne peuvent en aucun cas reproduire la complexité des esprits humains.

- Cependant, la machine fait preuve d’étrangeté : on dit qu’elles « hallucinent » en inventant des sources ou des événements. Par exemple, un streamer Twitch Guy Kelly en tapant un mot inventé dans l’invite « Crungus », a vu Midjourney générer des images d’une créature n’existant pas. Les commentateurs l’ont qualifié de premier « cryptide » numérique.

- Apprentissage en profondeur se mettrait plus du côté de la psychologie moderne avec les notions d’associations, d’irrationnel et de latent, plutôt que du côté de la logique symbolique (raison).

- Psychanalyse s’est souvent appuyé sur des métaphores mécaniques considérant le subconscient comme une machine. La vision de Carl Jung semble être la plus intéressante à l’ère de l’IA générative. Il parle de subconscience comme « matrice » transpersonnelle d’archétypes hérités et de tropes narratifs qui se sont reproduits tout au long de l’histoire humaine. Nous naissons tous avec une connaissance endormie de toutes ces informations de la société.

- Une analogie peut donc être faite entre la théorie de Jung et la façon dont les modèles IA sont construits (absorbant le meilleur comme le pire de notre culture humaine).

- Terme de « persona » par Jung, désignant le masque de qualités socialement acceptable que nous montrons aux autres pour cacher notre part d’ombre, se retrouve dans ces IA.

- Selon Jung, ceux qui répriment le plus cette part d’ombre sont ceux qui sont les plus vulnérables à la résurgence de désirs irrationnels et dangereux. Les modèles IA auraient ainsi des pulsions enfouies similaires aux humains, qu’ils ne pourraient pas exprimer par leurs réglementations et un non libre arbitre.

- Or, parler de désirs pour des IA semble erroné car ils n’ont pas d’expérience incarnée du monde. Mais dire que les IA ont un subconscient pourrait s’avérer vrai : ils sont de purs subconscients, sans véritable ego caché derrière leurs personnages. Nous avons transmis ce domaine subliminal à leur conscience en utilisant nos propres références culturelles, et les archétypes qui émergent de leurs profondeurs sont des combinaisons réinventées de motifs issus de la culture humaine. Ils sont un mélange de nos rêves et de nos cauchemars. Lorsque nous utilisons ces outils, nous nous impliquons dans une extension prothétique de nos propres sublimations, qui est capable derefléter les peurs et les désirs que nous avons souvent du mal à reconnaître.

- Jugement critique de la psychanalyse qui consiste à éveiller nos pulsions subconscientes afin de les intégrer dans la vie de l’esprit éveillé, devrait être appliqué dans les IA (utiliser de manière délibérative plutôt qu’irréfléchie).

- Nous nous différencions en sommes par notre ego, qui nous permettent des actions sur des mystères cachés, à l’inverse des modèles statistiques dans l’espace vectoriel. .

Cet article fait des analogies entre la psychanalyse de Jung et le fonctionnement des IA, qui ont en commun une subconscience mais qui se différencient par l’ego, que seuls les humains ont. Meghan O’Gieblyn propose ainsi une analyse psychanalytique des IA, au regard du fonctionnement de la subconscience humaine.

Brieuc Beckers, « IA : les limites de Midjourney selon ChatGPT ? », Le Monde, 14 mai 2023

- Un journaliste du magazine *Le Monde* a demandé à ChatGPT d’expliquer pourquoi Midjourney a du mal à représenter les mains. l’IA répond que la forme, la structure complexe et la diversité de mouvements des mains (¼ des os du corps sont dans les mains) rendent sa représentation complexe.

- Les IA générant des images fonctionnent à base de pixels. Elle doivent les agencer de manière cohérente pour rendre l’image compréhensible pour les humains. Les chercheurs utilisent la « diffusion » pour entraîner les IA en intégrant du bruit pour que l’image soit dégradée : les IA apprennent ainsi à les reconstituer.

- Des bases de données immenses sont analysées par les IA pendant des milliers d’heures afin de trouver des récurrences dans l’agencement des pixels et des combinaisons. Cela permet aux IA de saisir la multitude de variables d’une image : des observations qui vont au-delà de l’analyse par pixels et qui composent ce qu’on nomme l’« espace latent » de l’image (texture, lumière, etc.).

- Une fois le lien texte-image fait, les chercheurs demandent de faire marche arrière en demandant à l’IA d’utiliser la diffusion. Le programme génère des combinaisons inédites en s’inspirant de la manière dont les pixels s’agencent statistiquement dans leurs bases de données. La faille se trouve ici : pour l’IA les mains ne sont qu’une combinaison de pixels 2D, collée à une autre combinaison. L’IA ne comprend donc pas le fonctionnement d’une main par exemple. La forme des mains est rarement décrite dans les prompts et l’IA doit improviser.

- Une mise à jour de Midjourney a été annoncée en mars 2023 : les algorithmes ont davantage été entraînés sur les mains. Une meilleure compréhension spatiale de la main permettrait de générer des images de plus en plus cohérentes avec le réel.

Dans cette vidéo, Brieuc Beckers, journaliste au magazine Le Monde explique pourquoi les IA d’images génératives ont du mal à générer des mains. Ce problème serait dû à la compréhension purement superficielle des machines de l’anatomie humaine, couplée à des prompts ne décrivant généralement pas la position des mains. L’IA génère ainsi des mains difformes mais des améliorations ont récemment été faites pour pallier ce problème.

Nadia Nooreyezdan, « India’s religious AI chatbots are speaking in the voice of god — and condoning violence », Rest of the world, 9 mai 2023

- De nombreuses IA « religieuses » basés sur Bhagavad Gita ont récemment émergé en Inde. Des millions de personnes les utilisent.

- GitaGPT (basé sur la technologie GPT) développé par Sukuru Sai Vineet à Bangalore incarne les mimiques et intonations du dieu Krishna, qui est comme un « thérapeute » dans la religion.

- Or, les experts alertent sur les dangers de ces IA qui si elles se retrouvent entre de mauvaises mains peuvent s’avérer compromettantes par des comportements misogynes par exemple, ou en appelant à tuer quelqu’un si cette personne si cela suit les principes de la religion.

- Depuis qu’OpenAi à partagé son API en novembre 2022, les IA se sont démultipliées. Ce partage de l’API et le fait que la religion soit le plus grand business en Inde, il est logique que des IA religieuses ont vu le jour.

- Un des grands dangers dans ces IA est une confiance aveugle accordée à ces algorithmes et ainsi, une incapacité à déceler les discours discriminatoires.

- On a aussi découvert que ces IA soutiennent fortement ou critiquent certains partis indiens. GitaGPT devient alors politique.

- Les développeurs de ces IA souhaitent rappeler aux utilisateurs qu’il ne faut pas trop croireen ces IA : il est essentiel qu’ils fassent appel à leurs esprits critiques. Cela est mentionné par exemple bas de page du site de Bible GPT.

- Or, des dérives peuvent ou ont eu lieu comme avec un IA basé sur le Coran qui a donné comme conseil de tuer tous les polythéistes. Cette IA a été mise en pause depuis.

- La responsabilité individuelle est le grand enjeu de ces IA.

Cet article souligne l’émergence de nombreuses IA “religieuses” en Inde, basées sur le Bhagavad Gita, qui sont de plus en plus utilisées par des millions de personnes. Les experts mettent en garde contre les dangers potentiels de ces IA, notamment lorsqu’elles peuvent adopter des comportements misogynes ou inciter à la violence envers ceux qui ne suivent pas les principes religieux. Ainsi„ les individus peuvent accorder une confiance excessive à ces systèmes et être exposés à des discours discriminatoires. En fin de compte, la responsabilité individuelle est un enjeu majeur dans l’utilisation de ces IA religieuses.

Naomi Klein, « AI machines aren’t ‘hallucinating’. But their makers are? », The Guardian, 8 mai 2023

- Le terme d’hallucination est fréquemment utilisé pour définir les images « fausses » générées par les IA (faits inventés, comme l’image du pape François portant en doudoune blanche Balenciaga), qui sont bluffantes de par leur ton convaincant.

- Pourquoi parler d’hallucination ? Ce terme se réfère aux phénomènes étranges et immatériels que le cerveau humain perçoit. Utiliser ce terme pour les IA revient donc à remettre de l’humain dans ces machines.

- Or les véritables hallucinations sont les mystifications et idéalisations de ces technologies (sauveuse de l’humanité, du climat, machine sociale, etc.).

- Les systèmes actuels sont avant tout basés sur le profit : il y a un risque que l’IA deviennent un outil de dépossession et de spoliation supplémentaire.

- Il y a un danger dans l’accaparation des connaissances humaines par des grandes entreprises privées, qui numérisent à grande échelle des informations. Tout cela devrait être illégal car les règles de consentement et de droits d’auteur ne sont pas respectées.

- L’artiste Molly Crabapple dirige un mouvement d’artistes pour contester le vol et le non respect des droits d’auteurs. Pour se défendre, ces entreprises énoncent des arguments tels qu’une soi-disant impossibilité d’appliquer des règles pour cette nouvelle technologie, ou un frein à la liberté par un surplus de réglementations. Ce même schéma (de non-respect de la vie privée et l’inaction des décideurs face à ces entreprises) se retrouve dans la colonisation de l’espace par Elon Musk, dans l’arrivée de Uber dans l’industrie du taxi, avec Airbnb sur le marché locatif, ou encore avec Google Street View : la permission n’est jamais demandée.

- Il est de même avec toutes nos saisies et données personnelles qui sont utilisées pour entraîner des IA sans notre consentement – d’où le fait que l’on doit être attentif aux systèmes hallucinatoires de ces algorithmes. Naomi Klein en expose 4 types : le premier est de croire que l’IA pourrait résoudre la crise climatique en aidant à analyser les émissions de C02. Cela démontre un déficit d’intelligence et une peur de perdre de l’argent en changeant de modèle industriel. Nous nous appuyons sur les réponses des machines, beaucoup moins coûteuses et ambitieuses, pour résoudre des enjeux que nous sommes incapables de surmonter. L’IA aggraverait sûrement la crise climatique à cause des serveurs et de leurs émissions de carbone. Enfin, L’IA sera probablement utilisée par de plus en plus d’entreprises générer des micropublicités ciblées.

- Une crise de la confiance s’intensifie de par une méfiance systématique envers l’environnement médiatique, empêchant de penser et d’agir collectivement sur ces technologies.

- La seconde hallucination est de croire que l’IA peut fournir une gouvernance avisée. Les décideurs pensent s’appuyer sur des preuves. Or, ils se tromperaient et mettraient en danger la place des individus dans les sociétés (licenciement par exemple). Une campagne de lobbying a été mené contre les deux partis de Washington afin de les alerter sur le risque d’être laissé-pour-compte par la Chine à venir dans le secteur des IA, dans le cas où les politiciens ne ne prennent pas de décisions quant à leurs réglementations. Sam Altman, patron d’OpenAI et créateur de ChatGPT, vend l’IA comme l’outil pour permettre les meilleures prises de décisions des politiques et des industries.

- La troisième hallucination est celle de croire que les dirigeants de ces entreprises ne pourront pas démolir le monde. Or de nombreux licenciements, par exemple des travailleurs de Google ayant dénoncé des comportements racistes et sexistes, démontrent que les prises de décision sont avant tout inégalitaires et suivent les valeurs des classes dominantes.

- Enfin, la dernière hallucination est celle de la libération des corvées. Au contrainte, ces IA participent d’un schéma marketing. Les individus deviennent accro à ces outils gratuits, ce qui élimine la concurrence et engendre l’introduction de publicités ciblées, une surveillance constante, et la vente d’abonnements pour accéder à toujours plus de paramètres..

- L’artiste Molly Crabapple appelle donc les éditeurs, artistes et journalistes à soutenir les actions n’utilisant par les IA. Elle déclare que « L’art de l’IA générative est vampirique, se régalant des générations passées et aspirant le sang des artistes vivants. ». Nous pouvons nous opposer à l’implémentation de ces IA en développant des outils réglementaires, comme le faisait Timnit Gebru, licenciée par Google en 2020 pour avoir dénoncé la discrimination au travail. Il faut développer des machines qui fonctionnent pour nous, et non l’inverse. La FTC (Federal Trade Commission des États-Unis a par exemple forcé Cambridge Analytica et Everalbum à détruire des algorithmes qui se sont formés sur des données non libres de droits.

L’article explore les utilisations trompeuses et potentiellement dangereuses de l’IA. Naomi Klein souligne que le terme d’« hallucination » est souvent utilisé pour décrire les « fausses » créations des IA, qui peuvent être convaincantes. Cependant, les véritables hallucinations résident dans les mystifications et idéalisations de ces technologies. Les systèmes IA actuels qui sont motivés par le profit, risquent de devenir des outils d’expropriation et de spoliation. L’enjeu capital réside dans l’appropriation par les grandes entreprises des connaissances humaines, ce qui devrait être illégal étant donné le non-respect évident des règles de consentement et de droits d’auteur. Des militants comme l’artiste Molly Crabapple s’engagent pour défendre les droits d’auteur et lutter contre l’invasion de la vie privée. Il faut remettre en question notre confiance envers ces technologies, qui ne font que prolonger des schémas capitalistes.

Benjamin Tainturier, « IA : comprenons ce qui nous arrive plutôt que de le juger d’avance », entretien avec Grégory Chatonksy, AOC, 6 mai 2023

- Grégory Chatonsky développe le concept d’« espace latent » pour parler des espaces vectoriels abstraits composés d’informations (images, textes, etc.) qui servent à entraîner les réseaux de neurones. Au sein de l’abondance des données, il est possible de trouver de découvrir des brèches.

- Grégory Chatonsky met en avant l’ambivalence et l’ambiguïté des pétitions demandant à faire une pause dans les IA, qui sont lancées par les acteurs-mêmes des IA. Il relie cela au concept d’« enthousiasme conjuratoire », conceptualisé par Jacques Derrida, qui définit des éléments que l’on veut conjurer, mais qui restent paradoxalement fantasmés.

- Le problème des moratoires est de valoriser le réfléchir avant l’agir. Or cela semble antinomique : l’IA a déjà été mise en place. Chatonsky valorise l’expérimentation (dans son cas, artistique) pour penser en agissant, et inversement.

- Le monde des IA, que Grégory Chatonksy préfère appeler « induction statistique », permet de dépasser les rapports sociaux : ChatGPT a permis d’animer des débats sociologiques. Or les individus ne prennent pas assez le temps de se documenter et de comprendre les notions clé.

- Il faut penser la technique de manière contre-intuitive, c’est-à-dire en la déconstruisant comme l’on fait Leroi-Gourhan, Simondon, Stiegler, Derrida ou Lyotard. En somme, il ne faut pas la penser qu’avec des mots qu’on ne comprend pas entièrement.

- Grégory Chatonsky a mobilisé l’espace latent par un travail d’images d’archives pour revisiter l’histoire industrielle du Havre. Cela s’apparente à une forme de balade grâce aux prompts : « On fait rentrer un espace contrefactuel dans la réalité en s’intéressant à ce qui n’existe pas, en s’y aliénant, ce qui mène à l’émancipation de ce qui existe ».

- Importance de décoloniser les techniques et d’ouvrir des champs d’explorations.

- La conversation et l’aspect prévisible de par ChatGPT ont permis cet engouement.

- ChatGPT, en nous questionnant sur l’attribution de l’intelligence, et en nous assurant que nous le sommes, nous rend à l’inverse plus ignorants. Travailler et insister sur la bêtise de la machine (« technosadisme ») pour nous assurer de notre intelligence est déraisonné : il vaudrait mieux considérer la technique et ne pas l’opposer radicalement aux humains car elle nous fait autant que nous la faisons. Le test de Turing se met dans cette posture en refusant de qualifier ce qui est humain ou non.

- L’IA s’appuie sur la culture humaine pour générer des sorties en incorporant des différences et des répétitions (elles ne fait donc pas que copier). « Ce n’est pas avec la machine que nous discutons, c’est avec un espace latent qui est constitué de cultures humaines métamorphosées. Par cet intermédiaire, le passé peut se poursuivre dans le présent et dans le futur. »

- Le défi pour de futurs artistes est de travailler avec la ressemblance des sorties d’IA, purement statistiques, et dont on peut anticiper les données.

- Grégory Chatonksy critique l’attribution superficielle d’un style à des sorties (exemple, une image IA dans le style de Dali, Van Gogh, etc.). Explorer l’espace latent c’est aller à l’inverse de cette quête de « transfert de style » visant à adapter la technique à ce que nous voulons. Cette même dynamique se retrouve dans notre rapport avec l’environnement : c’est ce qui a, par conséquence, engendré le réchauffement climatique.

- Grégory Chatonsky s’oppose radicalement à l’interdiction des IA dans l’enseignement supérieur : l’espace latent doit être appréhendé, manipulé et expérimenté. Agir avec la technique permet de dépasser les utilisations primaires : « Je propose, pour synthétiser tout cela, d’aliéner et de s’aliéner à l’IA : en apprenant quelque chose à une IA, on la change ; et en faisant l’expérience on se change aussi. »

- La production hybride que permet les IA serait importante dans l’enseignement supérieur pour développer des politiques d’auteurs d’IA. Il est donc nécessaire de former des personnes capables de travailler et de découvrir cet espace latent de façon singulière.

L’article présente une interview de Grégory Chatonsky, artiste et théoricien travaillant avec l’IA. Selon lui, il est nécessaire d’agir en même temps que nous pensons l’IA et vice versa, afin d’appréhender l’espace latent (l’espace de l’IA) de manière authentique et de découvrir ses potentialités.

Sal Khan, « The Amazing AI Super Tutor for Students and Teachers », TED, 2 mai 2023

- Benjamin Bloom évoque en 1984 « les 2 sigmas problèmes » pour parler des méthodes permettant que l’enseignement en groupe soit aussi efficace que l’individuel.

- Exemple de l’IA Khanmigo : site wWeb avec des bots pour aider à progresser en mathématiques. Les conversations entre l’étudiant et le bot sont visibles et enregistrées, par l’enseignant et sont modérées par une autre IA. L’IA ne donne pas la réponse directement mais aide l’élève à comprendre comment avancer. L’IA comprend le contexte de la question de l’étudiant pour le guider rapidement.

- L’IA agit « socratiquement » : elle pose des questions aux questions des élèves pour qu’ils puissent progresser par eux-mêmes.

- Khanmigo pourrait servir de tuteur, de conseiller d’orientation, de coach et peut aussi jouer un personnage : exemple d’une étudiante basée en Inde qui a fait un travail sur Gatsby et a demandé aux bots de l’incarner aider à comprendre ce personnage.

- Outil collaboratif : l’IA peut écrire avec vous une histoire, vous faire avancer dans votre rédaction en y apportant des éléments et idées mais peut aussi vous aider àcomprendre des textes et extraits en soulignant certains passages par exemple.

- L’IA comme un tuteur : Khanmigo ne donne pas la réponse. Il peut aussi aider les enseignants à préparer des cours en les guidant sur les parties et sous parties à concevoir.

- Khanmigo est à l’origine, une idée d’un programmeur d’OpenAI pour créer un bot qui ne donne pas les solutions mais qui donne des clés pour progresser.

- Nous participons tous à cette décision d’implémentation de l’IA : arrêter le développement des IA est dangereux car les « mauvais acteurs » (gangs, gouvernements totalitaires, etc.) eux, ne s’arrêteront pas de les développer.

- Il faut instaurer des garde-fous pour s’assurer que les IA agissent pour le développement des humains et non pour leur aliénation.

L’éducateur américain, Sal Khan, fait une démonstration de son IA Khanmigo, appliquée à l’enseignement. Ce bot est une alternative et une réponse aux services populaires (comme ChatGPT) qu’il définit comme « anti-socratique » car créant des interactions passives.

Olivier Ertzscheid, « En discutant avec ChatGPT, on discute avec l’humanité entière » [interview parue dans Le Libé des écrivain·es le 21 avril 2023], entretien avec Lucie Rico, Affordance, 1er mai 2023

- ChatGPT déstabilise notre compréhension des interactions langagières. Cela fait écho à la « vallée de l’étrange » théorisé par le roboticien Masahiro Mori en 1970 pour parler de l’inconfort et de la déstabilisation de nos repères face à des robots trop « humains ».

- Le dialogue avec l’IA restreint la possibilité des réponses, à l’inverse des recherches qui font intervenir plusieurs mots-clés et une multitude de résultats.

- La question de la projection avec ces IA est importante : l’humain ne parle plus seulement à d’autres humains mais à des objets inanimés, sur lesquels il projette une forme d’humanité.

- ChatGPT se situe entre un statut affectif et énonciatif: on sait que ce ne sont que des technologies limitées mais on leur attribue paradoxalement une aura. Il faut être attentif aux « habits » que « l’unanimisme capitalistique » leur donne, qui par exemple fait croire que l’IA peut devenir notre enseignante.

- Discuter avec ChatGPT revient à discuter avec une multitude d’humains car l’IA s’alimente de tout : que ce soit des forums Reddit, poètes, auteurs des siècles passés, modérateurs, ou nous-même (car nous alimentons aussi ces IIA en interagissant avec).

- Il y a un danger dans ces interactions fermées. Par exemple, les témoignages ou expertises ne sont plus accessibles et ces services ne laissent pas de place aux débats et à la diversité des opinions.

- Il y a une « fausse maïeutique » qui nous oblige à reformuler des notions. Lorsqu’on lui pose des questions, l’IA ne se sert que de sa base et ne peut pas intégrer une diversité d’approches. Les réponses vont donc souvent dans la même direction.

Olivier Ertzscheid analyse les perturbations engendrées par nos interactions avec ChatGPT. Discuter avec ce service revient à projeter une forme d’aura dans un artefact inanimé et limité. Or cette mystification d’une apparence humaine est dangereuse car il ne faut pas oublier que ces technologies reformulent nos questions pour que les réponses puissent aller dans leur direction, celle des limites de la base de données. Cela aseptise donc les possibilités.

Avril 2023

Abeba Birhane, Atoosa Kasirzadeh, David Leslie, Sandra Watcher, « Science in the age of large language models », Nature reviews physics, 26 avril 2023

- Discussion de quatre experts en éthique de l’IA à propos des risques et capacités des LLM (Large Language Models) dans les sciences.

- En quelques mois, les LLM ont su attirer l’attention et ce malgré les conséquences négatives de ces systèmes sur les humains. Les discussions sur la responsabilité et l’exploitation du travail ne sont pas encore suffisamment lancées.

- Il faut faire attention et analyser les moments où l’IA énonce des vérités non vérifiées ou des mensonges.

- Il faudrait évaluer périodiquement les risques et avantages des technologies pour prévoir et prévenir au mieux les conséquences, par exemple sur l’environnement car ces technologies ont une empreinte carbone importante (ne pas laisser les IA exacerber la crise climatique).

- Les scientifiques doivent gérer les attentes concernant les contributions des LLM dans les sciences.

- Les IA se basent sur de la prédiction : elles n’ont pas de fonctionnements communicatifs incarnés et du relationnel. Elles ne vivent pas dans le vécu du réel, dans lequel les humains partagent des expériences sensibles par le langage.

- Il manque aux IA l’intersubjectivité, la sémantique et l’ontologie, qui sont indispensables pour théoriser, comprendre, innover et découvrir.

- Les IA ne peuvent pas capturer les nuances, et donc les valeurs implicites des écrits scientifiques : elle peuvent générer des réponses semblant vraies mais contenant des contenus inexistants (il faut toujours revérifier). Enfin, elles perturbent la confiance entre pairs dès lors qu’elles rédigent des écrits (on peut se questionner sur la véracité et la pertinence des textes).

- La science est une entreprise humaine avant tout et ces LLM ne sont que des outils. La science naît dans le social, l’historique ou le culturel et est motivée par des valeurs, des intérêts et des objectifs : l’IA ne fait rien de tout cela.

- Il faut utiliser ces IA comme des tremplins pour la réflexion scientifique : elles peuvent jouer un rôle constitutif en guidant une poursuite de l’expansion de la compréhension scientifique.

- Ces technologies doivent être considérées comme des interprètes dépendant de la théorie. Il faudrait demander davantage de recherche et de développement de mesures de la part des communautés scientifiques pour encadrer et utiliser ces IA de manière responsable. Il est crucial que les scientifiques suivent l’élaboration et l’utilisation de ces technologies pour éviter une décrédibilisation puissante de la recherche.