@AnthonyMasure

Résister aux boîtes noires

Design et intelligences artificielles

Colloque MCRIDD, Tunis, ISAMM / Campus de la Manouba, 26–28 septembre 2018

Résumé

Le regain d’intérêt pour l’intelligence artificielle (IA) des années 2010 engendre des programmes auto-apprenants (deep learning) et potentiellement incontrôlables (black boxes). Ces IA « créatives » investissent progressivement les capacités d’invention et d’imagination, et tendent donc à se substituer aux tâches communément attribuées aux designers. Sous couvert de rentabilité, le risque est alors que le design ne devienne qu’une puissance de production de marchandises et de motifs (patterns) automatisés. Face au formatage des expériences humaines dans ce qu’elles ont de plus singulier, quelles marges de manœuvre peut-on inventer ? Des contre-pouvoirs sont-ils encore envisageables ?

—

Éléments biographiques

Le design des programmes, des façons de faire du numérique

Thèse en esthétique, dir. Pierre-Damien Huyghe, univ. Paris 1, 2014

Revue de recherche Back Office

no 1, « Faire avec », 2017

Revue de recherche Back Office

no 2, « Penser, classer, représenter », 2018

Design et humanités numériques, Paris, B42, 2017

« Post-numérique ou post-politique ? », conf. à l’ESSTED Tunis, avril 2017

1 —

L’époque des

« boîtes noires »

1.1 —

Balistique et cybernétique comme horizon du design

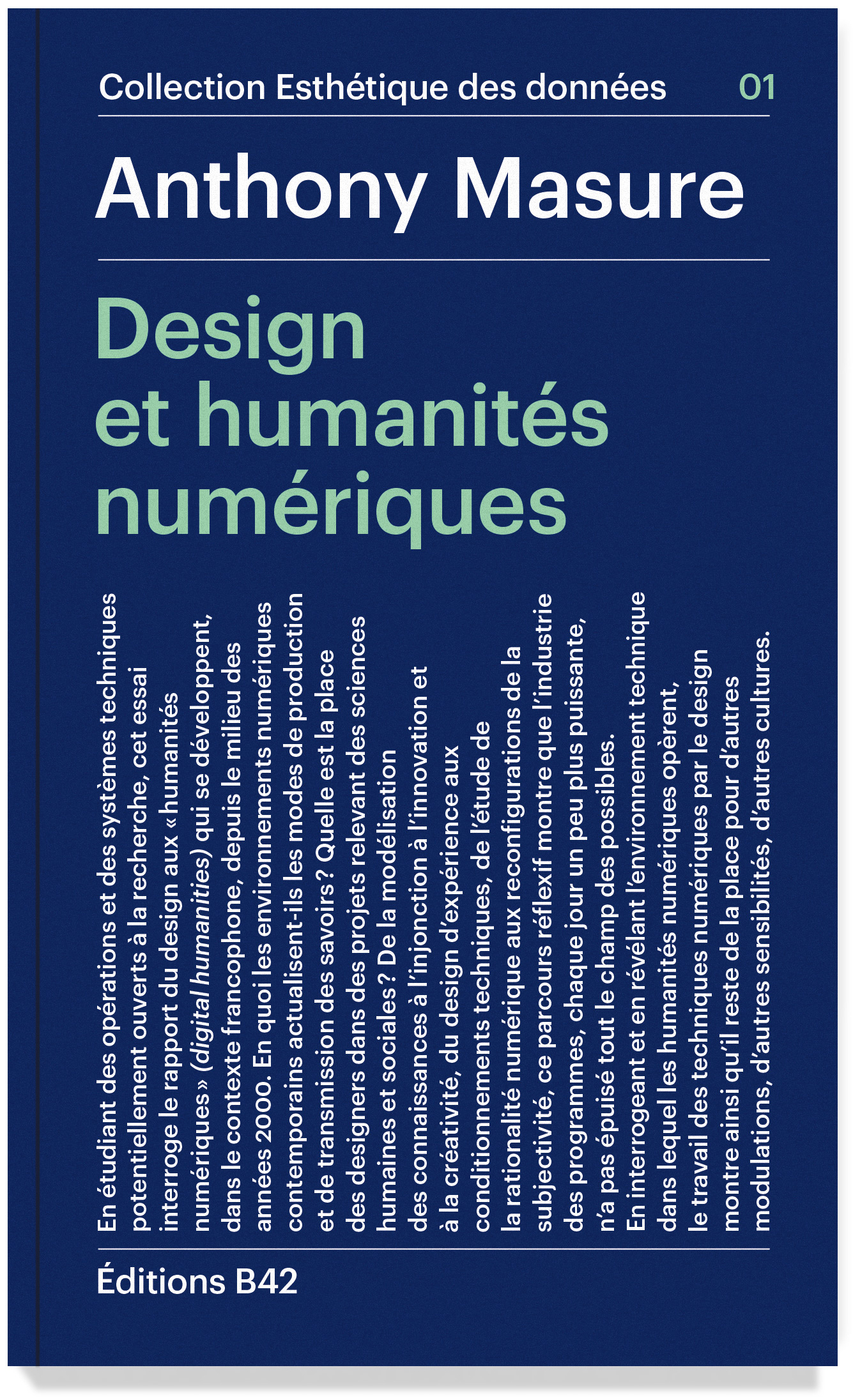

Carte de ravitaillement de Berlin Est par les alliés, 1948

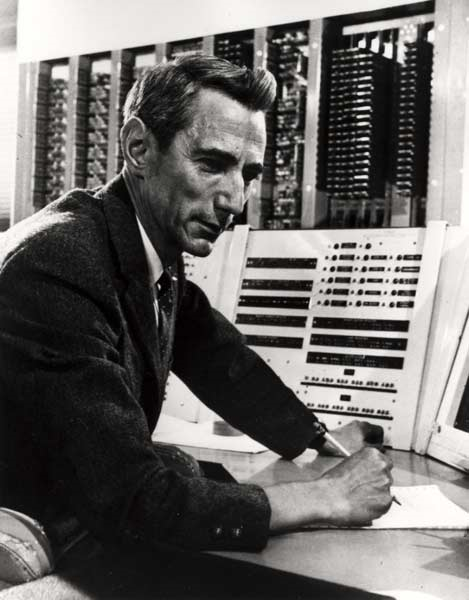

Claude Shannon (1916-2001)

Une « théorie entière de la commande et de la communication, aussi bien chez l’animal que dans la machine ».

— Norbert Wiener, La cybernétique. Information et régulation dans le vivant et la machine, 1952

Pour expliquer le concept de « boîte noire », Norbert Wiener utilise l’exemple d’une machine se substituant à un organisme pour incarner la possibilité de remplacer un système par un autre sans connaître le détail de l’architecture du système considéré.

« C’était l’époque où des psychiatres construisaient des machines, où des logiciens s’occupaient du cerveau humain, où des mathématiciens assemblaient des cerveaux artificiels, où des anthropologues cherchaient des ‹ modèles › expliquant les comportements humains. »

— Philippe Breton, Histoire de l’informatique, Paris, La découverte, 1987

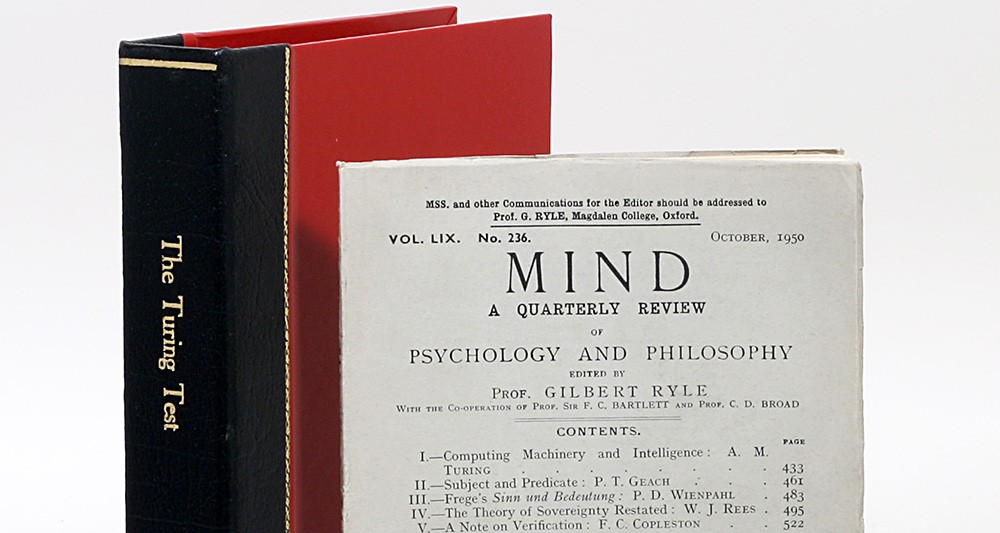

Alan Turing (1912–1954)

Alan Turing, « Computing machinery and intelligence », Mind,

Oxford University Press, vol. 49, no 236, octobre 1950

Alan Turing, « Computing machinery and intelligence », 1950

Remplacer « la question les machines peuvent-elles penser ? » par : « un ordinateur peut-il tenir la place d’un être humain dans le jeu de l’imitation » ?

« On peut espérer que les machines finiront par concurrencer les hommes dans tous les champs intellectuels. Mais quels sont les meilleurs pour commencer ? C’est une décision difficile. Beaucoup de gens pensent qu’une activité très abstraite, comme le jeu d’échecs, serait la meilleure. Il se peut qu’il soit préférable [de] suivre l’enseignement normal d’un enfant. […] Je ne sais pas quelle est la bonne réponse, mais je pense que les deux approches devraient être essayées. »

— Alan Turing, « Computing machinery and intelligence », 1950

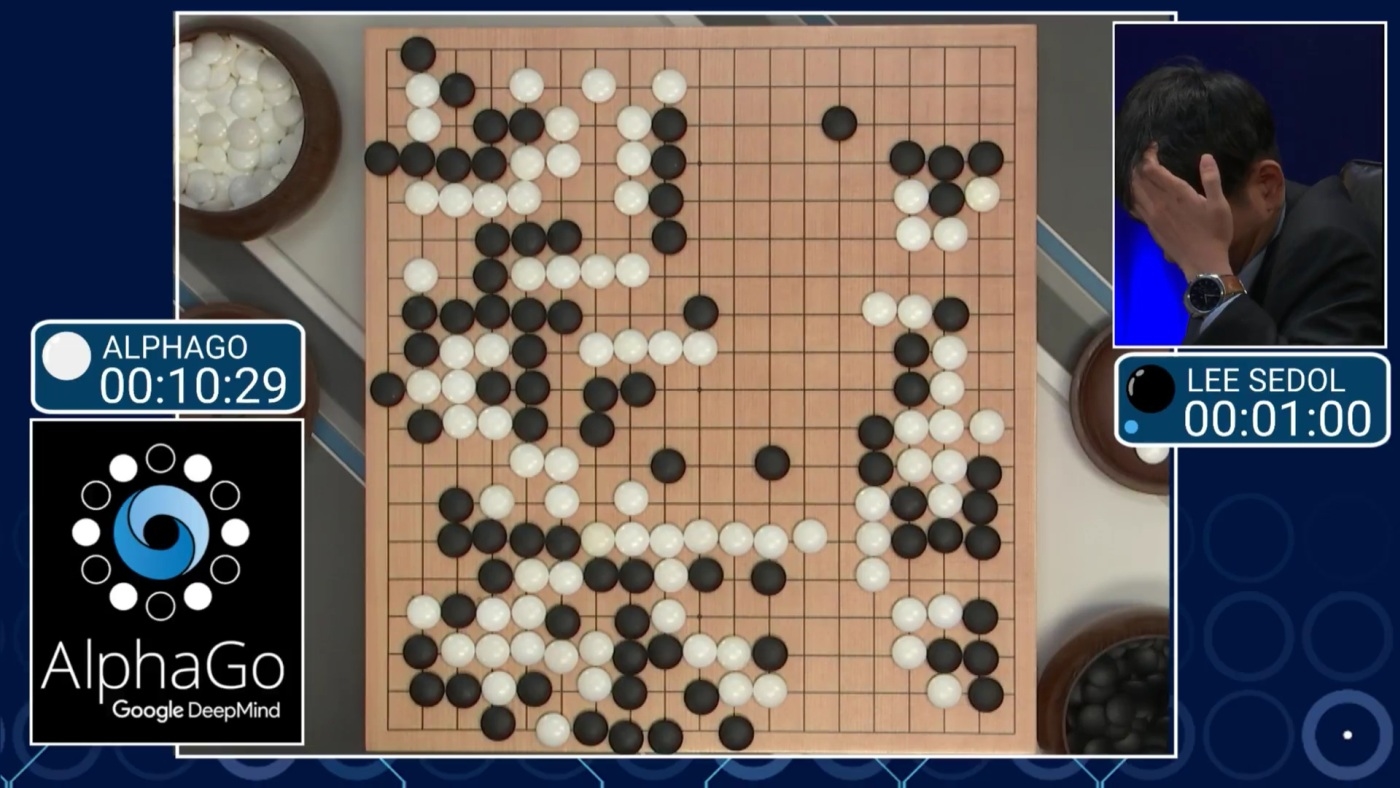

Garry Kasparov VS IBM Deep Blue, 1997

Lee Sedol VS Google DeepMind AlphaGo, 2017 (deep learning)

1.2 —

Passage de la cybernétique dans l’informatique personnelle

Stafford Beer, salle des opérations du projet Cybersyn, Chili, 1973

Modèle du contrôle, science du pilotage (kubernêtês)

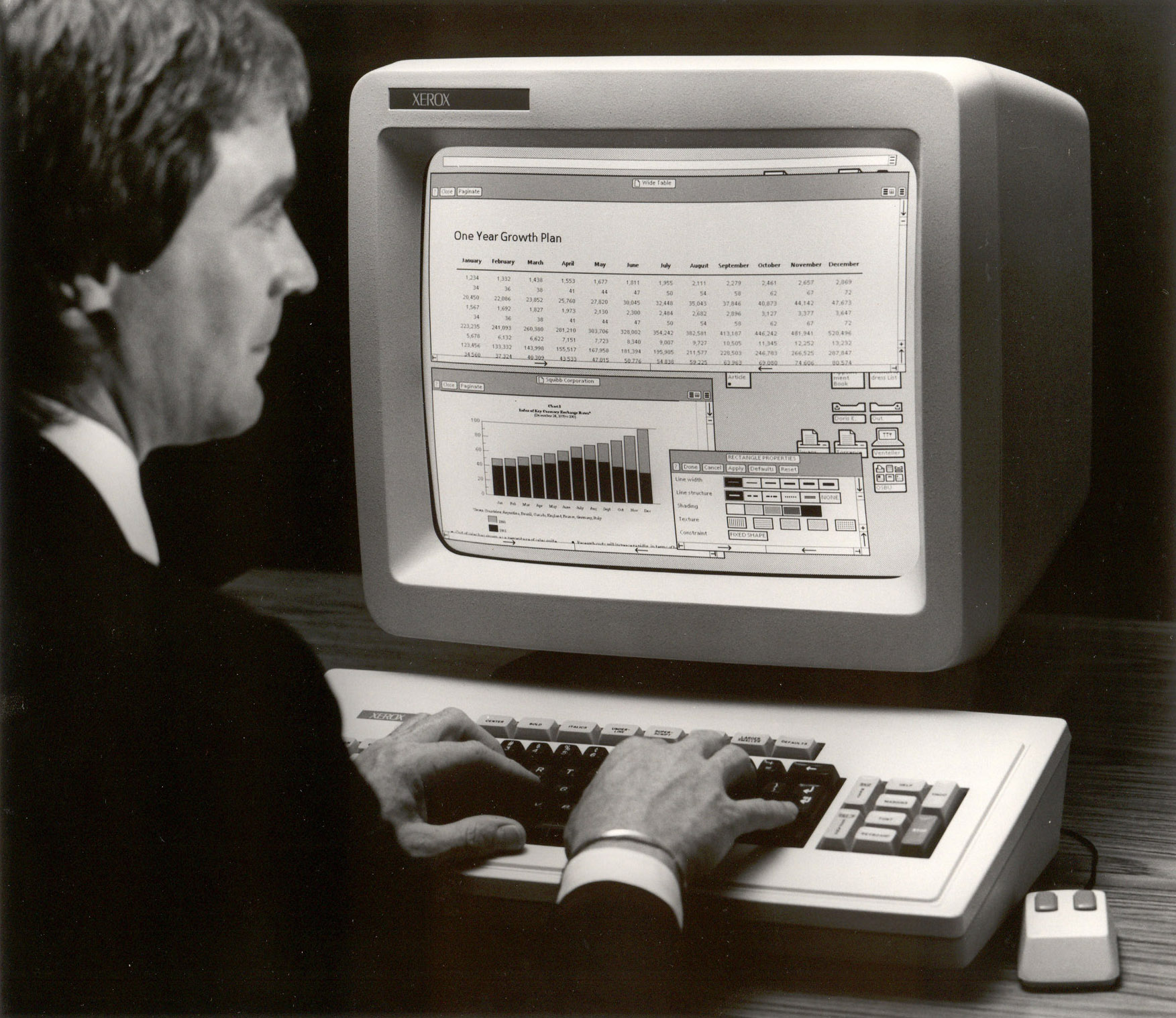

Xerox Star, interface WYSIWIG, 1981

« La description de la tâche actuelle avec sa répartition des objets et des méthodes d’information actuellement employées offre un point de départ pour la définition d’un ensemble équivalent d’objets et de méthodes devant être fournis par le système informatique [l’ordinateur, ses programmes et ses périphériques]. L’idée derrière cette phase de conception est de construire un nouvel environnement des tâches pour l’utilisateur, dans lequel il puisse travailler pour atteindre les mêmes objectifs qu’avant, désormais entouré d’un ensemble différent d’objets, et en employant de nouvelles méthodes. »

— David Canfield Smith, Charles Irby, Ralph Kimball, Bill Verplank, Eric Harslem, « Designing the Star User Interface », Byte, no 4, 1982

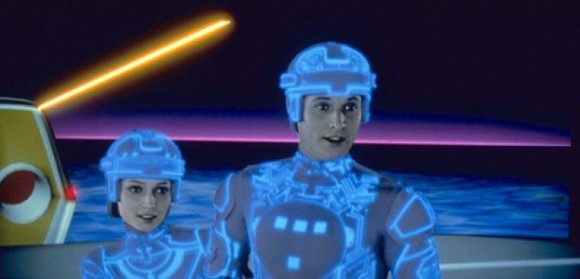

Tron, 1982. « Master Control Program: You’re in trouble, program.

Why don’t you make it easy on yourself. Who’s your user? »

« Flynn : Je suis ce que vous appelez un ‹ utilisateur ›…

Tron : Eh bien, si vous êtes un utilisateur, alors tout ce que vous avez fait l’a été selon un plan, n’est-ce pas ?

Flynn : (rires) Vous aimeriez que cela soit le cas… Vous savez ce qu’il faut faire, vous continuez à faire ce que vous faites – même si cela a l’air absurde.

Tron : C’est comme ça avec les programmes en effet. Mais…

Flynn : Je déteste te décevoir mon pote, mais la plupart du temps c’est comme ça aussi pour les utilisateurs. »— Film Tron (1982), cité par Eugene Thacker dans : A. Galloway, Protocol. How Control Exists after Decentralization, MIT Press, 2004

Passage de la cybernétique dans l’informatique personnelle

- Importance du concept de « boîte noire » dans le développement de l’informatique personnelle

- L’utilisateur est une fiction du processus de conception

- Entrelacement entre les notions de programme et d’utilisateur : qui programme qui ?

- Risque d’un « usage inhumain des êtres humains » (Wiener), alliage de la technologie, de la politique et du capitalisme

1.3 —

Vivre dans les programmes

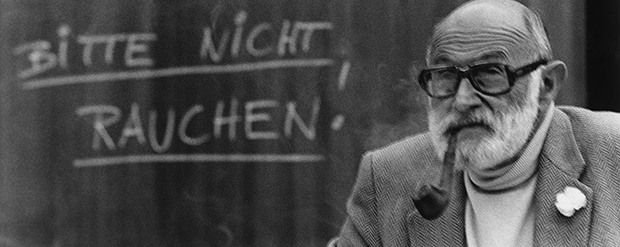

Vilém Flusser (1920–1991)

Vilém Flusser, Pour une philosophie de la photographie [Filosofia da Caixa Preta. Ensaios para uma futura filosofia da fotografia, 1983], Paris, Circé, 1998

Pour Flusser, la photographie fait partie des « techno-images » produites par des appareils. L’apparente objectivité des images techniques est illusoire et dangereuse, puisqu’elles ne signifient pas le monde monde extérieur mais les textes cachés des programmes « boîtes noires ». En l’absence d'un point de vue critique et d’un travail artistique, nous courons le risque de rester analphabètes des images et d’être programmés par les machines.

« La compétence de l’appareil doit être supérieure à celle de ses fonctionnaires. Aucun appareil photo correctement programmé ne peut être entièrement percé à jour par un photographe […]. C’est une black box. […] Même si, dans sa quête de possibilités, il se perd à l’intérieur de son appareil, il peut maîtriser la boîte. Car il sait comment alimenter l’appareil (il connaît l’input de la boîte), et sait également comment l’amener à cracher des photographies (il connaît l’output de la boîte). […] Voilà ce qui caractérise le fonctionnement de tout appareil : le fonctionnaire est maître de l’appareil grâce au contrôle qu’il exerce sur ses faces extérieures (sur l’input et sur l’output), et l’appareil est maître du fonctionnaire du fait de l’opacité de son intérieur. En d’autres termes, les fonctionnaires sont maîtres d’un jeu pour lequel ils ne sauraient être compétents. Kafka. »

— Vilém Flusser, Pour une philosophie de la photographie [1983], Paris, Circé, 1998, p. 36

« La boîte, qu’elle soit appareil photo ou média, tend automatiquement à nous dévorer. Les photographes essaient de duper les boites pour leur faire produire de l’information. C'est la lutte entre la liberté humaine et ses propres dispositifs. Chaque photographie témoigne isolément de cette lutte. »

— Vilém Flusser, « Comment ne pas être dévoré par la boîte », 14e Rencontres Internationales de la Photographie, Arles, 9 juillet 1983

Vilém Flusser, « Le geste d’écrire », 1976–1984

Vilém Flusser, Does writing have a future? [1987], trad. de l’allemand par Nancy Ann Roth, University of Minnesota Press, 2011

Vilém Flusser, « Programme (Tes père et mère honoreras) », 1986

« Les robots peuvent honorer notre père et notre mère à notre place. Ils peuvent le faire mieux que nous, avec plus de précision, d’efficacité et de pertinence. Tout comportement est théoriquement mécanisable : pensées, sentiments, et mêmes les inspirations les plus transcendantes. Si difficulté il y a, elle n’est que pratique. »

— Vilém Flusser, « Programme (Tes père et mère honoreras) » [1986], à paraître dans Multitudes, dossier « Vivre dans les programmes », dir. Yves Citton et Anthony Masure

Vivre dans les programmes

- L’écriture linéraire devient unidimensionnelle et indéchiffrable

- les machines programmeront automatiquement d’autres machines

- Les appareils techniques nous transforment en fonctionnaires des machines

- Risque d’une société automatisée

1.4 —

Politiques de l’opacité

Frank Pasquale, Black Box Society. Les algorithmes secrets qui contrôlent l’économie et l’information, trad. de l’anglais par Florence Devesa et Phil Adams, Roubaix, FYP, 2015

« Surveiller les autres tout en échappant soi-même à la surveillance est l’une des plus hautes formes du pouvoir. »

— Frank Pasquale, Black Box Society, 2015

Vivre dans les programmes

- Difficulté à énoncer une critique des programmes, qui mettent en doute les anciennes catégories de pensée

- Dangers de l’opacité et idéologies de la transparence

- Programmé / Être programmé

2 —

Rapide histoire de l’intelligence artificielle

2.1 —

De la Seconde Guerre mondiale aux années 1990

Deux approches rivales

- Modéliser les « lois universelles » de la pensée

- Imiter les processus biologiques cérébraux (logique connexionniste)

Excès d’optimisme

- 1958, Herbert Simon et Allen Newell : « D’ici dix ans un ordinateur sera le champion du monde des échecs » et « d’ici dix ans, un ordinateur découvrira et résoudra un nouveau théorème mathématique majeur. »

- 1965, Herbert Simon : « Des machines seront capables, d’ici vingt ans, de faire tout travail que l’homme peut faire. »

- 1967, Marvin Minsky : « Dans une génération […] le problème de la création d’une ’intelligence artificielle’ [sera] en grande partie résolu. »

- 1970, Marvin Minsky (dans le magazine Life) : « Dans trois à huit ans nous aurons une machine avec l’intelligence générale d’un être humain ordinaire. »

Quelques dates clé

- 1974-1980 : Première « hibernation » de l’intelligence artificielle

- 1982 : John Hopfield démontre qu’un « réseau neuronal » peut apprendre et traiter de l’information d’une manière totalement inédite

- 1987-1993 : Second « hiver » de l’IA (chute de l’IA symbolique, celle des « systèmes experts »)

2.2 —

Depuis 1993, la domination du Deep Learning

Paradigme dominant de l’« apprentissage profond »

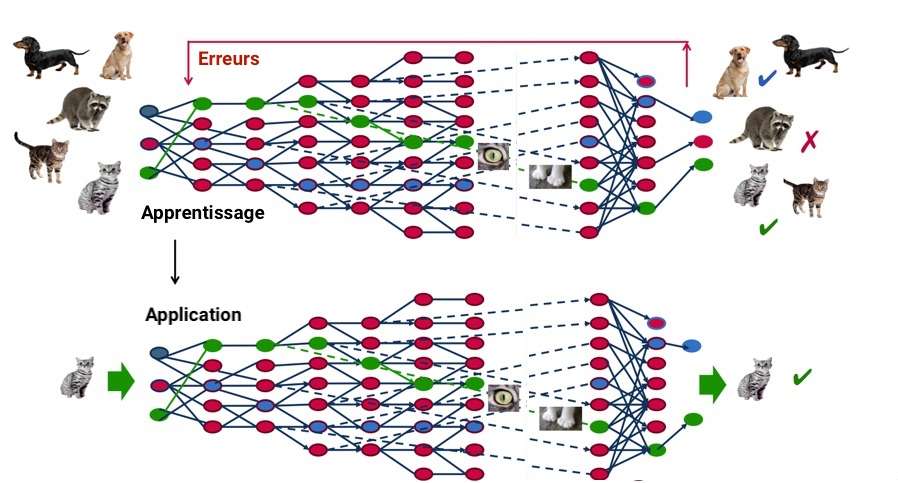

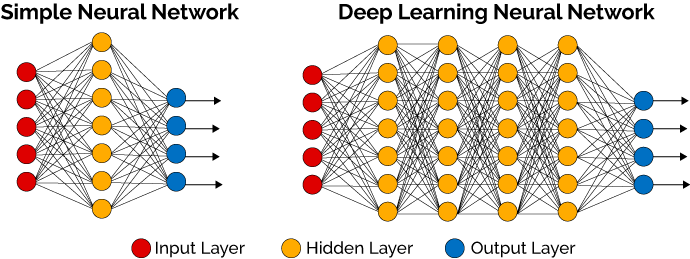

Le deep learning, ou « apprentissage profond », est un type d’intelligence artificielle dérivé du machine learning (apprentissage automatique) où la machine est capable d’apprendre par elle-même, contrairement à la programmation où elle se contente d’exécuter des règles prédéterminées.

Fonctionnement du deep learning

Le deep learning est une technologie d’apprentissage automatique basée sur un réseau de « couches » neurones artificiels s’inspirant du cerveau humain. Le système apprendra par exemple à reconnaître les lettres avant de s’attaquer aux mots dans un texte, ou détermine s’il y a un visage sur une photo avant de découvrir de quelle personne il s’agit. À chaque étape, les « mauvaises » réponses sont éliminées et renvoyées vers les niveaux en amont pour ajuster le modèle mathématique. Au fur et à mesure, le programme réorganise les informations en blocs plus complexes. Les données de départ sont essentielles : plus le système en accumule plus il est sensé être performant.

Fonctionnement du deep learning

2.3 —

Apppliquer des modèles à des données

Tensor Flow, Google, 2015–

Watson, IBM, 2011–

« Les tâches effectuées par les systèmes d’IA sont souvent conçues pour des contextes limités afin de réaliser des progrès pour la résolution d’un problème ou une application précise. Alors que les machines peuvent obtenir des performances spectaculaires sur une tâche spécifique, ces performances peuvent se dégrader considérablement si la tâche en question est modifiée même légèrement. »

— Stanford, « Index de l’IA », 2018

Enjeux du deep learning

- Rigidité des avancées techniques

- Importance et biais des jeux de données (ex. Chine)

- Privatisation des modèles technologiques

- Approche cognitiviste du monde

3 —

La prise de pouvoir de l’ingénierie cognitive

Constat

- Frilosité du marché, peur de l’échec commercial

- Survalorisation de la culture de l’ingénieur

- Volonté d’expliquer le monde et de trouver des « solutions »

- Déclin de la psychanalyse et montée en puissance des sciences cognitives

« Sciences de la cognition, paradis inconnu des designers », Cog’Innov

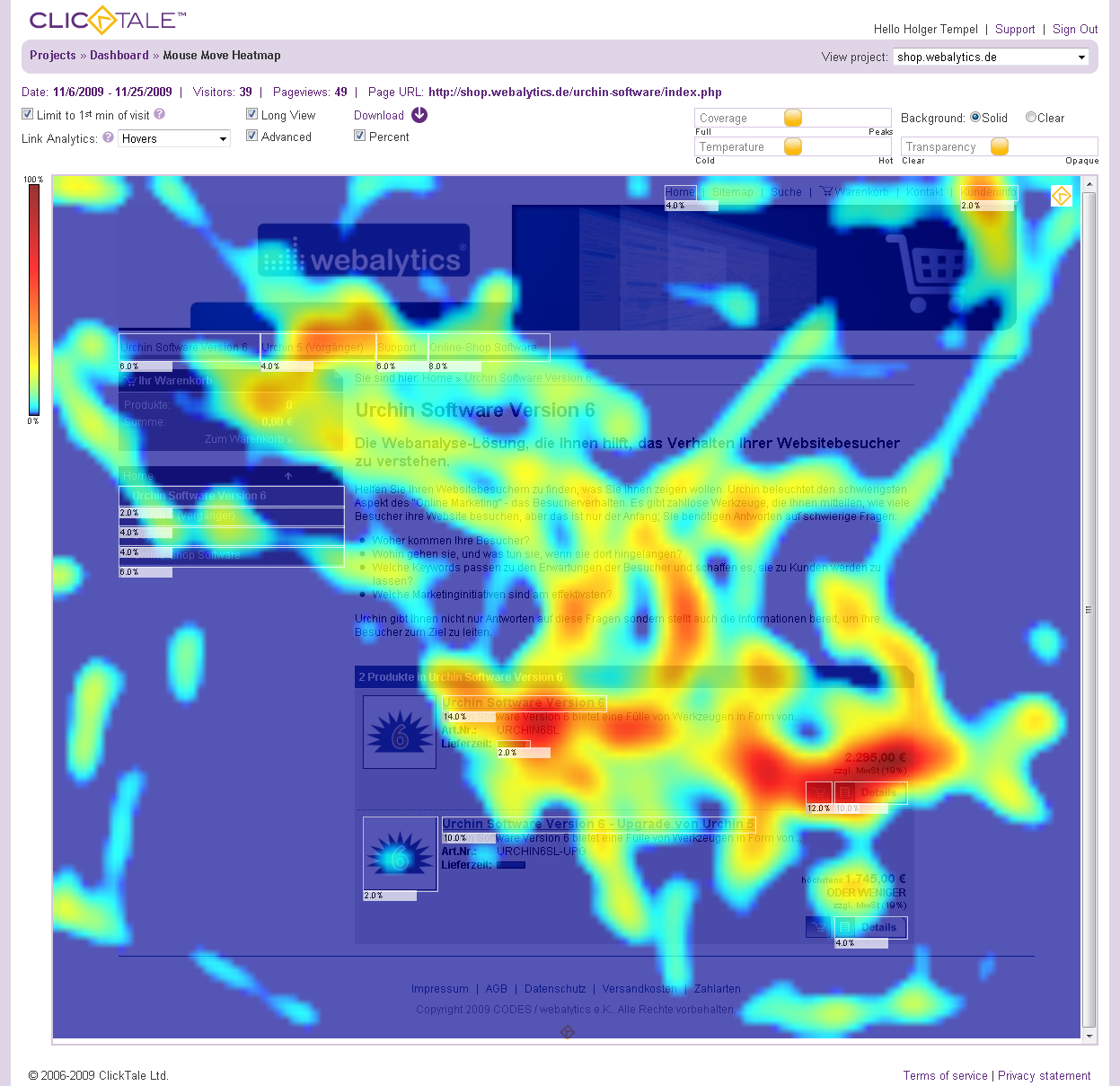

Web heatmap & analytics : l’économie des gestes et du regard

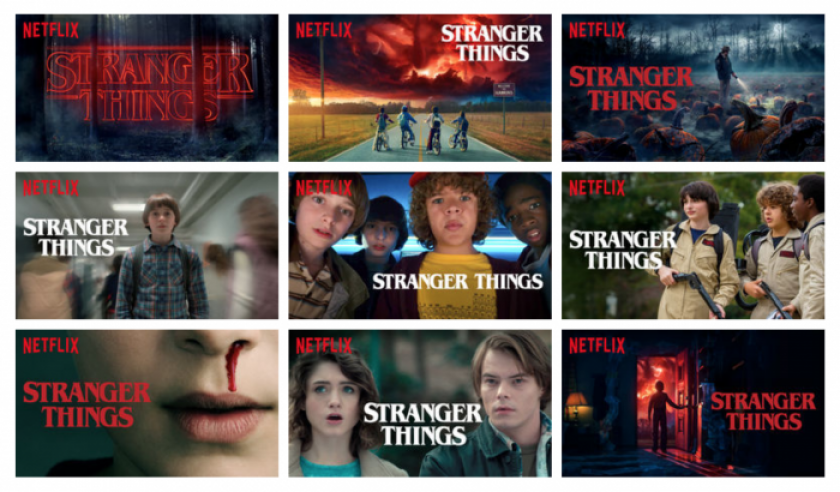

L’économie de l’attention. Guillaume Ledit, « Comment Netflix choisit les images des séries selon votre profil », Usbek & Rica, décembre 2017

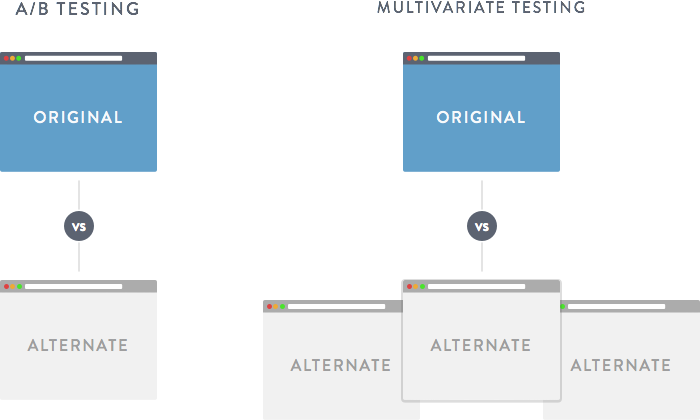

Les A/B testing, ou l’obsession de la mesure

« Lorsqu’une entreprise est remplie d’ingénieurs, elle se tourne vers l’ingénierie pour résoudre les problèmes. Réduire chaque décision à un simple problème de logique. Supprimer toute subjectivité et uniquement regarder les données. […] Et ces données finissent par devenir une béquille pour chaque décision, paralysant l’entreprise et l’empêchent de prendre des décisions de conception audacieuses. Oui, c’est vrai qu’une équipe de Google ne pouvait pas choisir entre deux bleus, alors ils ont testé 41 nuances de bleu pour voir lequel était le plus performant. […] J’en ai eu assez de débattre de ces minuscules décisions de conception. Il y a des problèmes de conception plus passionnants à résoudre dans ce monde. »

— Douglas Bowman, « Goodbye, Google », mars 2009

Problèmes

- Approche « solutionniste » du design (Evgeny Morozov)

- Vocabulaire problématique à déconstruire

(« utilisateur », « expérience », « solution », etc.) - Perte de confiance dans l’intuition des designers

- Quid de la dimension esthétique ?

« L’histoire du design UX est, jusqu’à très récemment, l’histoire du design définie par d’autres domaines. Notre domaine a d’abord été défini par les ingénieurs car, soyons honnêtes, ce sont eux qui ont inventé Internet. Et leur définition du design – des gens avec des bonnets cools qui mettent des couleurs partout – est encore largement acceptée par une grande majorité des designers. C’est la voie de la facilité. […] Nous avons passé les vingt dernières années à prouver notre légitimité aux ingénieurs qui pensaient que nous étions une perte de temps. Jusqu’à ce qu’ils réalisent que nous pouvions amplifier leur puissance de façon exponentielle. »

— Mike Monteiro, « Design’s Lost Generation », Medium, février 2018

4 —

Implications des IA dans le champ du design

4.1 —

Applications générales

Application du deep learning

Exploration de données ; robotique industrielle ; logistique ; reconnaissance vocale ; applications bancaires ; diagnostics médicaux ; reconnaissance de formes ; moteurs de recherche, etc.

Quelques professions concernées

- Taxis (voitures autonomes)

- Journalistes (bots d’écriture)

- Avocats (algorithmes prédictifs)

Google, voiture autonome, 2010–

Rester sur sa ligne : « The Audi active lane assist », 2010

— « Robot journaliste : en un an, une IA créée par le Washington Post a publié 850 articles », Numerama.com, septembre 2017

DoNotPay (robot avocat), 2017

4.2 —

Le cas des interfaces à commande vocale

« Assistants vocaux »

« Assistants vocaux » embarqués dans des enceintes connectées

Enjeux des assistants vocaux

- Disparition des interfaces graphiques

- Démultiplication de l’effet « boîte noire »

- Perte du sens critique lié au passage dans le visible

4.3 —

Passage des IA dans le champ « créatif »

The Next Rembrandt, Microsoft, 2018

TheGrid.io, 2016

Adobe Sensei, 2016

Zalando, Fashion-MNIST dataset (60 000 sprites)

Balenciaga AI, Robbie Barrat, 2018

4.3 —

Pour une critique des IA « créatives »

Problèmes des IA « créatives »

- Disparition progressive des tâches d’exécution

- Fantasme d’une automatisation de la création

- Modélisation (mathématisation) simpliste du design

- Fin de la « friction » expérimentale

5 —

Conclusion

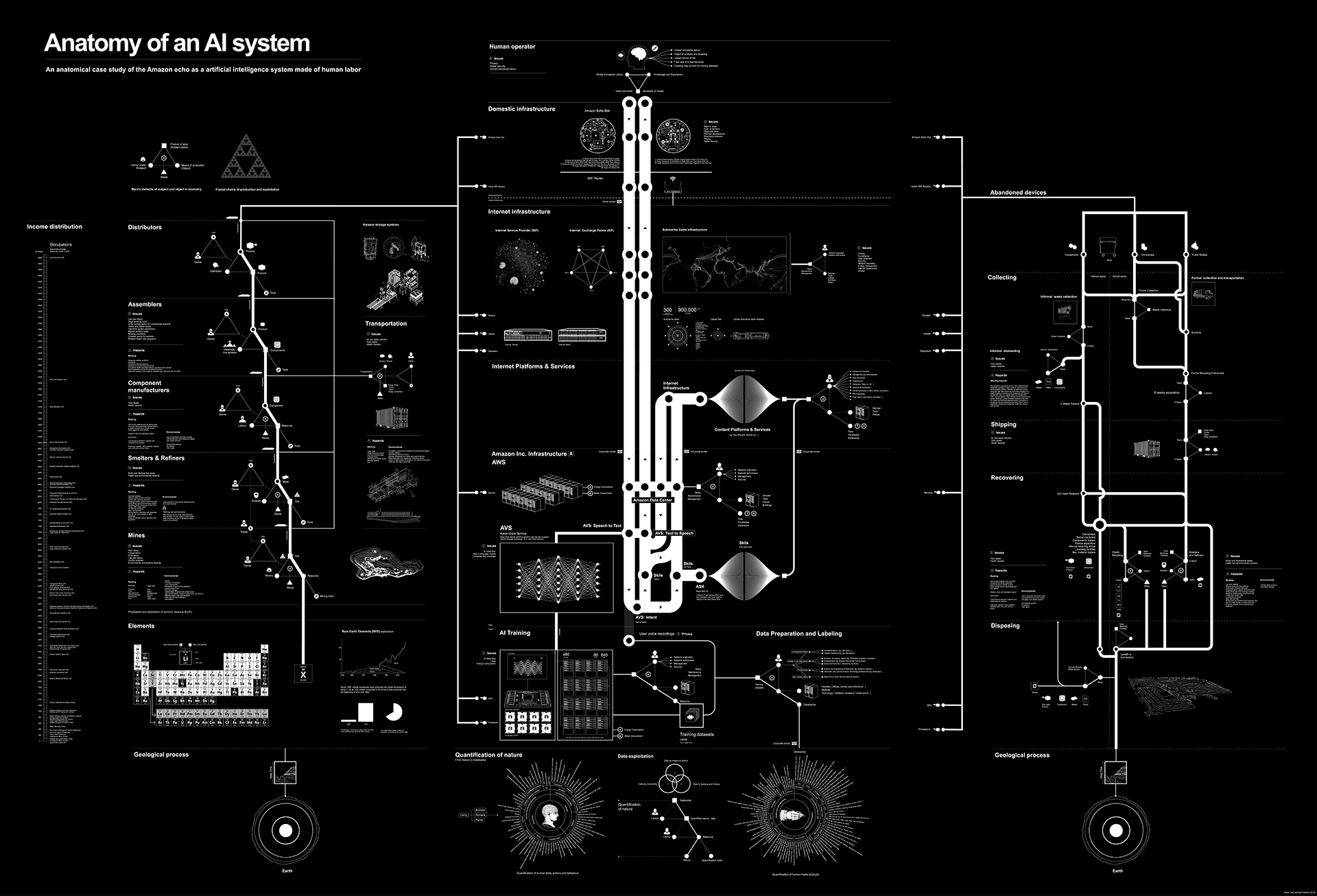

Kate Crawford, Vladan Joler, « Anatomy of an AI System » [Amazon Echo], 2018

Raphaël Bastide, Twins, performance, 2016

Directions de travail

- Ne pas surestimer les IA créatives

- Se méfier des biais liés aux données initiales

- Déconstruire les logiques capitalistes des IA dominantes

- Dépasser l’opposition humain/machine

- Relire Alan Turing (le sens émerge du bruit)

- Jouer avec les IA !

@AnthonyMasure

www.anthonymasure.com

—

Présentation conçue avec Reveal.js (MIT License)

Crédits typo : Skolar Sans (Rosetta Type) & Input (David Jonathan Ross)