@AnthonyMasure

Responsable de la recherche à la HEAD – Genève (IRAD – Institut de Recherche en Art et en Design)

Membre associé du laboratoire LLA-CRÉATIS, université Toulouse – Jean Jaurès

Apprendre des abysses :

les humanités numériques face aux machines du deep learning

Journées d’étude « Humanités numériques et computationnelles »,

Université Côte d’Azur, Académie d’Excellence « Homme, Idées et Milieux »

Nice, Centre Universitaire Méditerranéen, 6 septembre 2019

Problématique

Quelle est la pertinence de l’expression « humanités numériques » à l’époque des « boîtes noires » du

deep learning ?

1 —

(Très) rapide histoire des intelligences artificielles

« On peut espérer que les machines finiront par concurrencer les hommes dans tous les champs intellectuels. […] Beaucoup de gens pensent qu’une activité très abstraite, comme le jeu d’échecs, serait la meilleure. Il se peut qu’il soit préférable [de] suivre l’enseignement normal d’un enfant. […] Je ne sais pas quelle est la bonne réponse, mais je pense que les deux approches devraient être essayées. »

— Alan Turing, « Computing machinery and intelligence », 1950

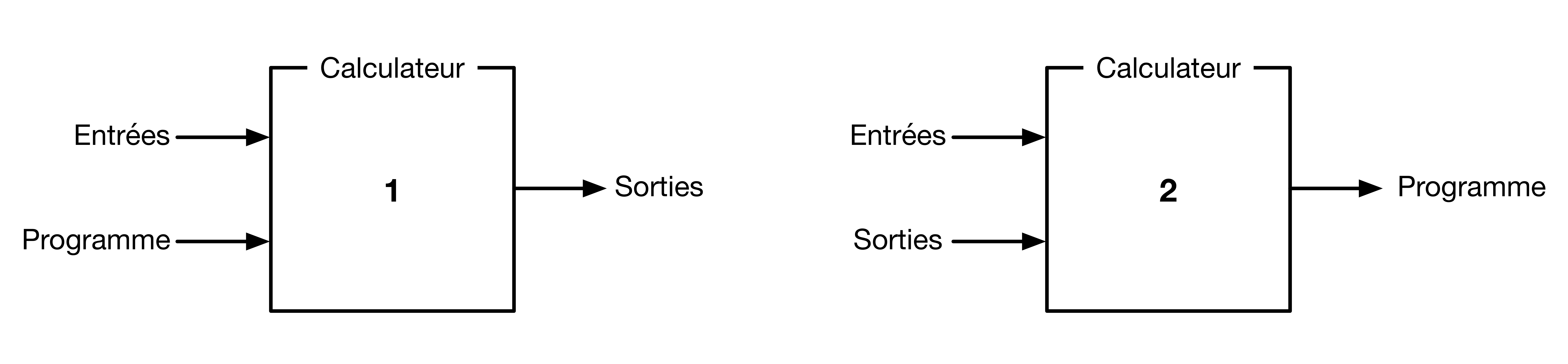

Les IA, deux approches rivales

- Modéliser a priori (en amont) l’ensemble des possibilités et comportements de la machine

→ logique symbolique - Permettre à la machine d’apprendre par elle-même en imitant les processus biologiques cérébraux

→ logique connexionniste

Machine hypothético-déductive (1) et machine inductive (2)

Dominique Cardon, Jean-Philippe Cointet et Antoine Mazières,

« La revanche des neurones », Réseaux, no 211, novembre 2018

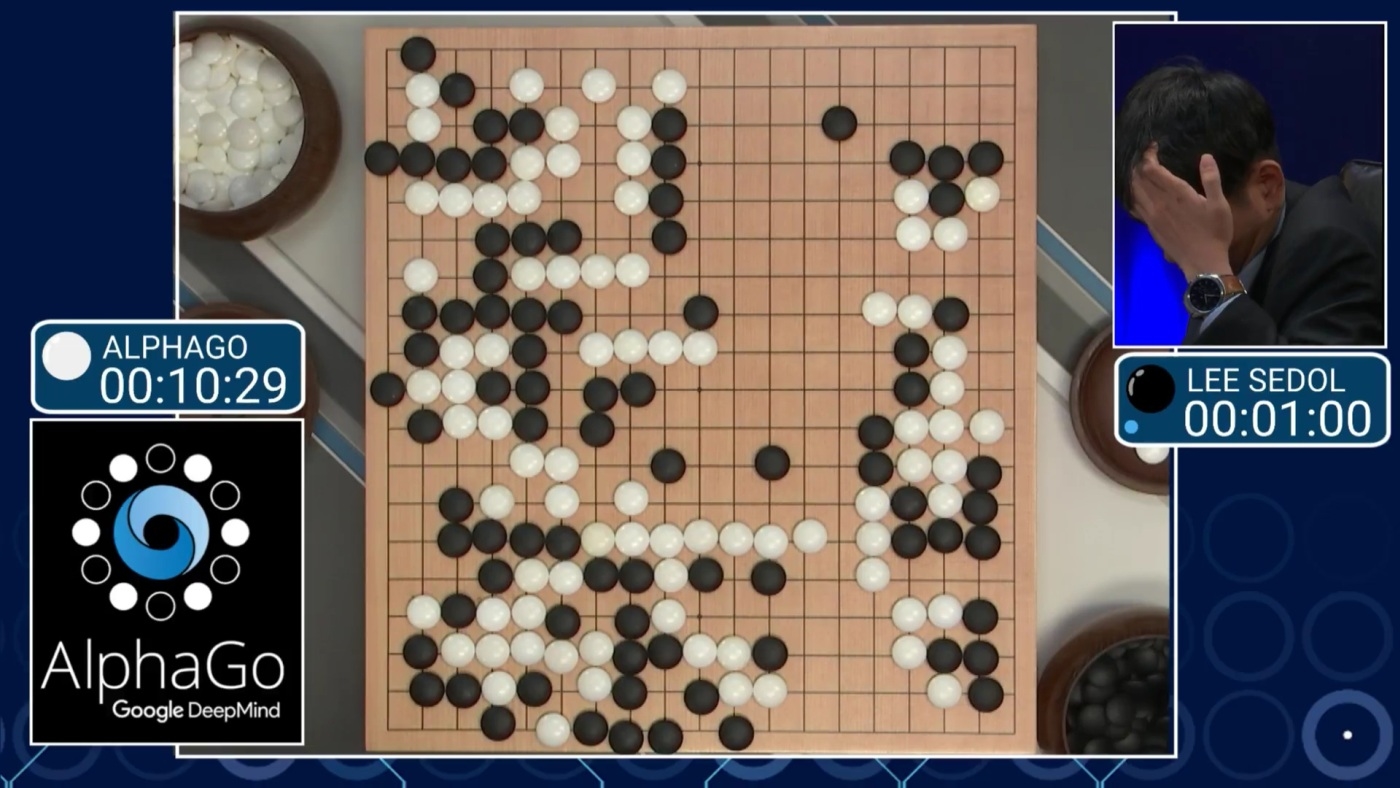

Garry Kasparov VS IBM Deep Blue, 1997

Lee Sedol VS Google DeepMind AlphaGo, 2017 (deep learning)

« L’architecture des machines à prédire va être transformée pour affronter les big data […] : de nouveaux problèmes d’ingénierie à base de grands volumes de données comme la détection de spams, les techniques de filtrage collaboratif utilisées pour la recommandation, la prédiction de stock, la recherche d’information ou l’analyse des réseaux sociaux. »

— Dominique Cardon, Jean-Philippe Cointet et Antoine Mazières,

« La revanche des neurones », Réseaux, no 211, novembre 2018

2 —

Les boîtes noires

du deep learning

2.1 —

Fonctionnement

du

deep learning

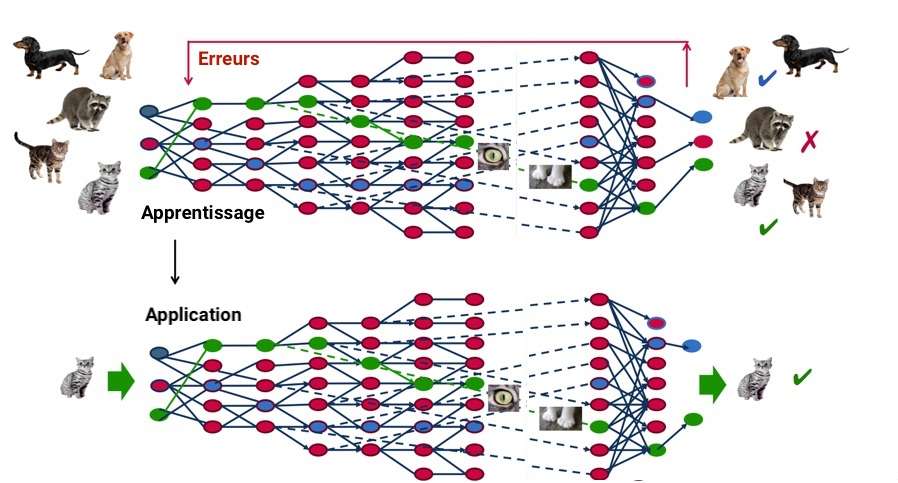

L’apprentissage profond

Le deep learning, ou « apprentissage profond », est un type d’intelligence artificielle dérivé du machine learning (apprentissage automatique) où l’idéal est d’élaborer une machine est capable d’« apprendre par elle-même », contrairement à la programmation « traditionnelle » où elle se contente d’exécuter des règles prédéterminées.

Fonctionnement du deep learning

2.2 —

Applications du deep learning :

une rhétorique de l’alerte et de la performance

« Aura-t-on vraiment le choix ? Le rapport Jobs Lost, Jobs Gained (2017) du McKinsey Global Institute estime que

‹ 50 % des emplois ont le potentiel d’être automatisés avec les technologies actuelles. › ‹ Nos scénarios dans 46 pays suggèrent qu’entre zéro et un tiers des activités pourraient être remplacées en 2030. D’ici là, 75 à 375 millions de travailleurs devront changer de domaine ›, précisent les experts. »

— Maïlys Khider, « Ces 25-35 ans qui ne veulent plus faire carrière »,

Le Figaro Madame, avril 2019

Applications du deep learning

Exploration de données, robotique industrielle, logistique, reconnaissance vocale, applications bancaires, diagnostics médicaux, reconnaissance de formes, moteurs de recherche, etc.

Google, voiture autonome, 2010–

« Robot journaliste : en un an, une IA créée par le Washington Post

a publié 850 articles », Numerama.com, septembre 2017

DoNotPay (robot avocat), 2017

« Assistants vocaux » embarqués dans des enceintes connectées

(Amazon Alexa, Google Home, etc.)

2.3 —

L’IA comme illusion de

travail machinique

Antonio Casilli, En attendant les robots, Paris, Seuil, 2019

2.4 —

Genéalogies cybernétiques

de la « boîte noire »

« Nous voulons […] accepter la possibilité […] qu’une équipe d’ingénieurs puisse construire une machine qui fonctionne, mais dont les modalités de fonctionnement ne peuvent être décrites de manière satisfaisante par ses concepteurs, parce qu’ils ont appliqué une méthode en grande partie expérimentale. »

— Alan Turing, « Computing machinery and intelligence », 1950

Pour expliquer le concept de « boîte noire », Norbert Wiener utilise l’exemple d’une machine se substituant à un organisme. Il est donc possible de remplacer un système par un autre sans connaître le détail de son fonctionnement interne.

Les boîtes noires du deep learning

Quelles sont les conséquences d’un paradigme technique reposant sur l’invisible et l’inintelligible ?

3 —

Vilém Flusser,

vivre dans les programmes

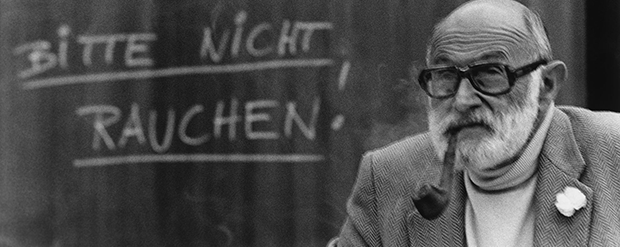

Vilém Flusser (1920–1991)

Dossier « Vilém Flusser : vivre dans les programmes »,

dir. Yves Citton et Anthony Masure, Multitudes, no 74, avril 2019

Dossier « Vilém Flusser : vivre dans les programmes »,

dir. Yves Citton et Anthony Masure, Multitudes, no 74, avril 2019

3.2 —

(Auto)programmation des

comportements humains

« La compétence de l’appareil doit être supérieure à celle de ses fonctionnaires. Aucun appareil photo correctement programmé ne peut être entièrement percé à jour par un photographe […]. C’est une black box. […] Voilà ce qui caractérise le fonctionnement de tout appareil : le fonctionnaire est maître de l’appareil grâce au contrôle qu’il exerce sur ses faces extérieures (sur l’input et sur l’output), et l’appareil est maître du fonctionnaire du fait de l’opacité de son intérieur. »

— Vilém Flusser, Pour une philosophie de la photographie [1983], 1998, p. 36

« La boîte, qu’elle soit appareil photo ou média, tend automatiquement à nous dévorer. Les photographes essaient de duper les boites pour leur faire produire de l’information. C'est la lutte entre la liberté humaine et ses propres dispositifs. Chaque photographie témoigne isolément de cette lutte. »

— Vilém Flusser, « Comment ne pas être dévoré par la boîte »,

14e Rencontres Internationales de la Photographie, Arles, 9 juillet 1983

« Les robots peuvent honorer notre père et notre mère à notre place. Ils peuvent le faire mieux que nous, avec plus de précision, d’efficacité et de pertinence. Tout comportement est théoriquement mécanisable : pensées, sentiments, et mêmes les inspirations les plus transcendantes. Si difficulté il y a, elle n’est que pratique. »

— Vilém Flusser, « Programme (Tes père et mère honoreras) » [1986], dans : dossier « Vivre dans les programmes », dir. Yves Citton et Anthony Masure, Multitudes, no 74, avril 2019

Vilém Flusser, Post-histoire [1982], postface de Yves Citton,

préface de Anthony Masure, Paris, T&P Work UNiT, 2019

Vilém Flusser, vivre dans les programmes

- L’écriture devient unidimensionnelle et indéchiffrable

- Les machines programmeront d’autres machines

- Les appareils nous transforment en « fonctionnaires »

des machines : nous nous « auto-programmons » - Difficulté à énoncer une critique des programmes, qui mettent en doute les anciennes catégories de pensée

4 —

Sonder les abysses :

vers un monde vampyroteuthique

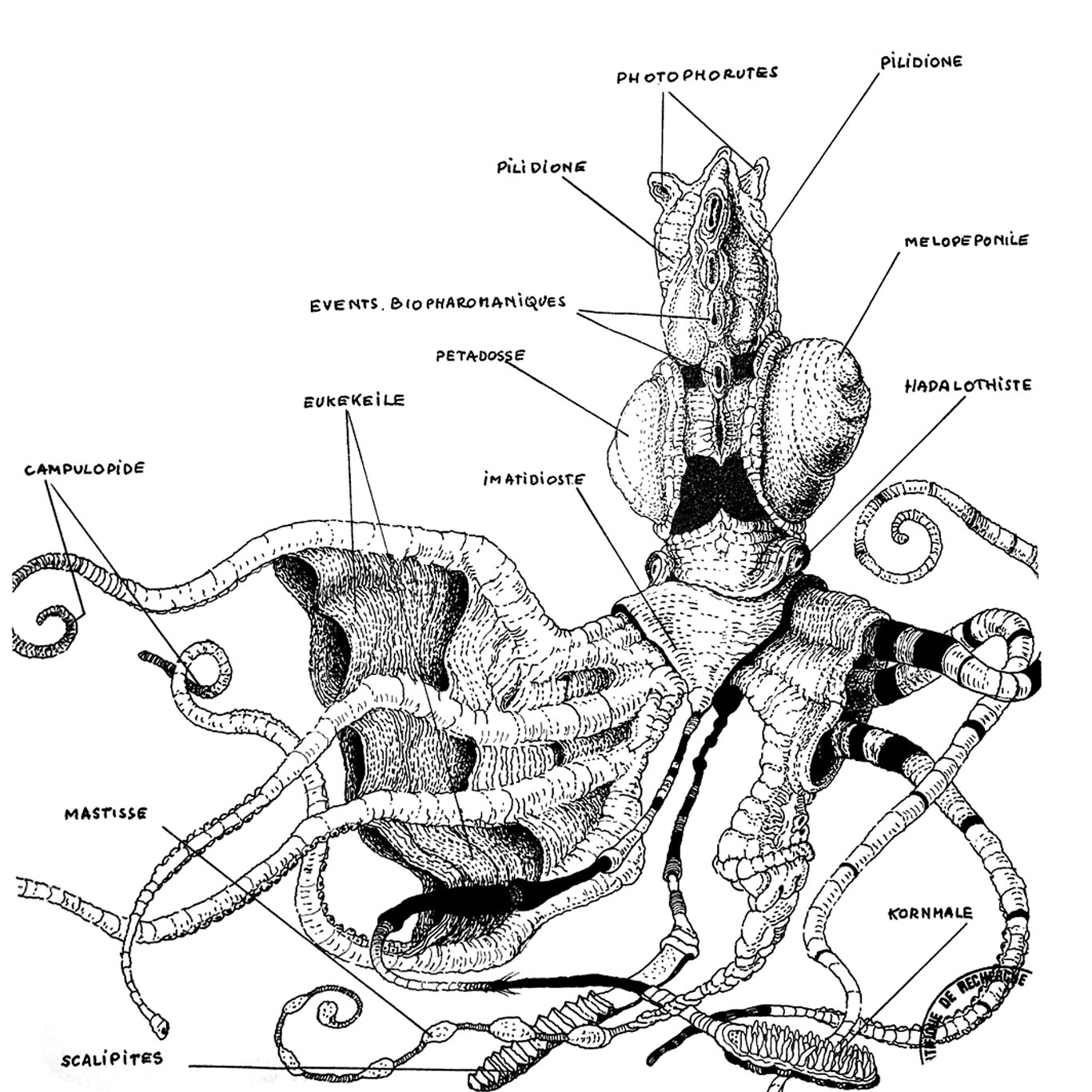

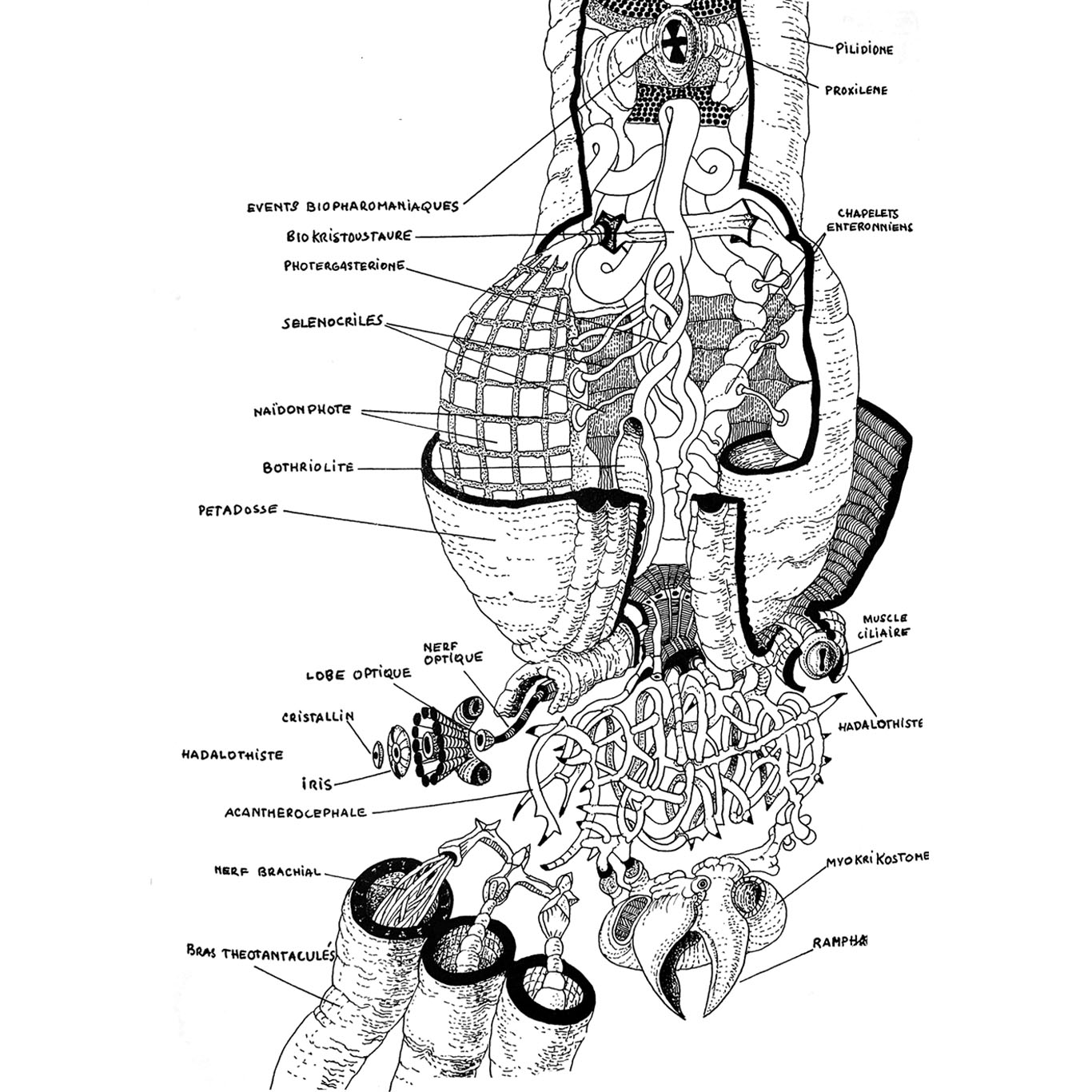

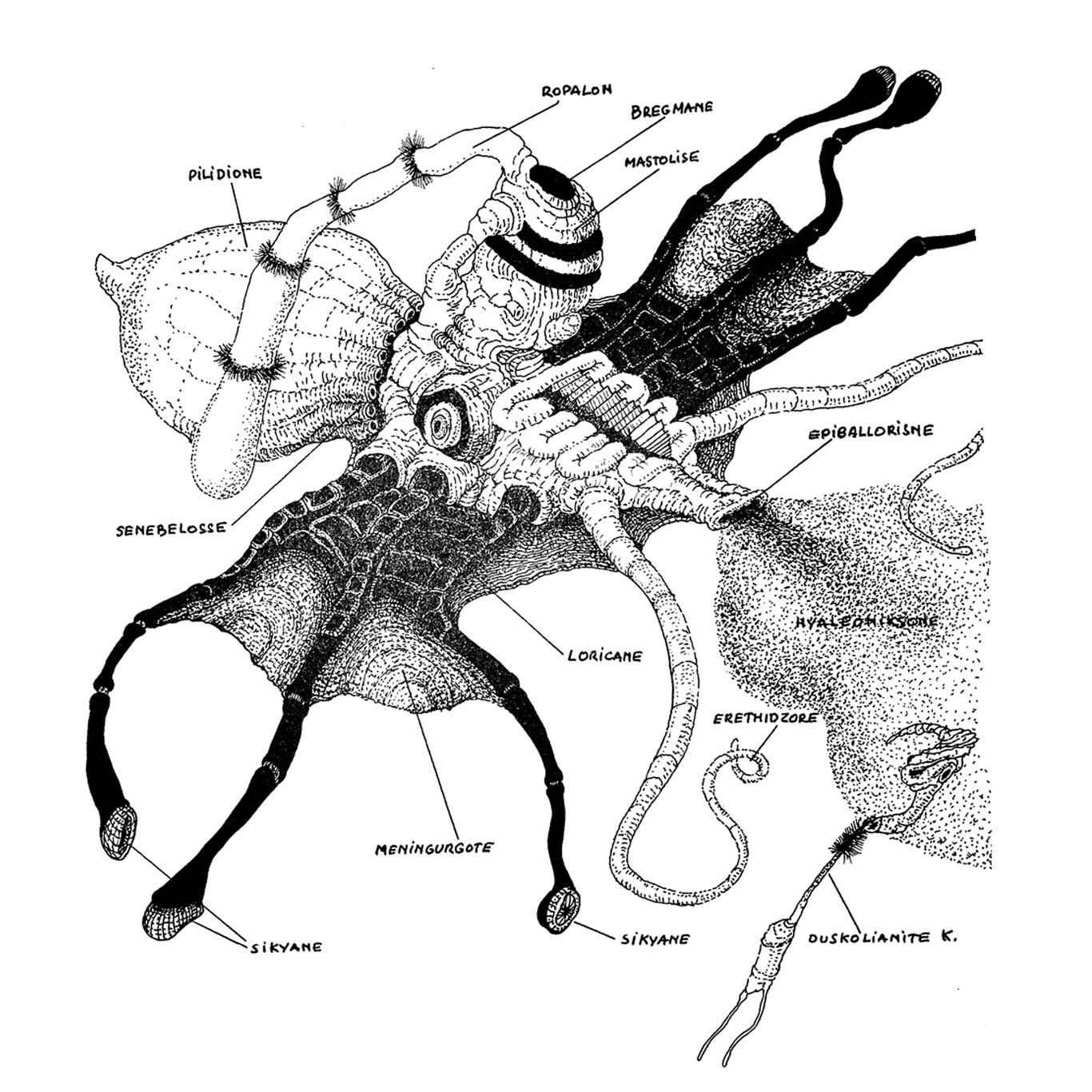

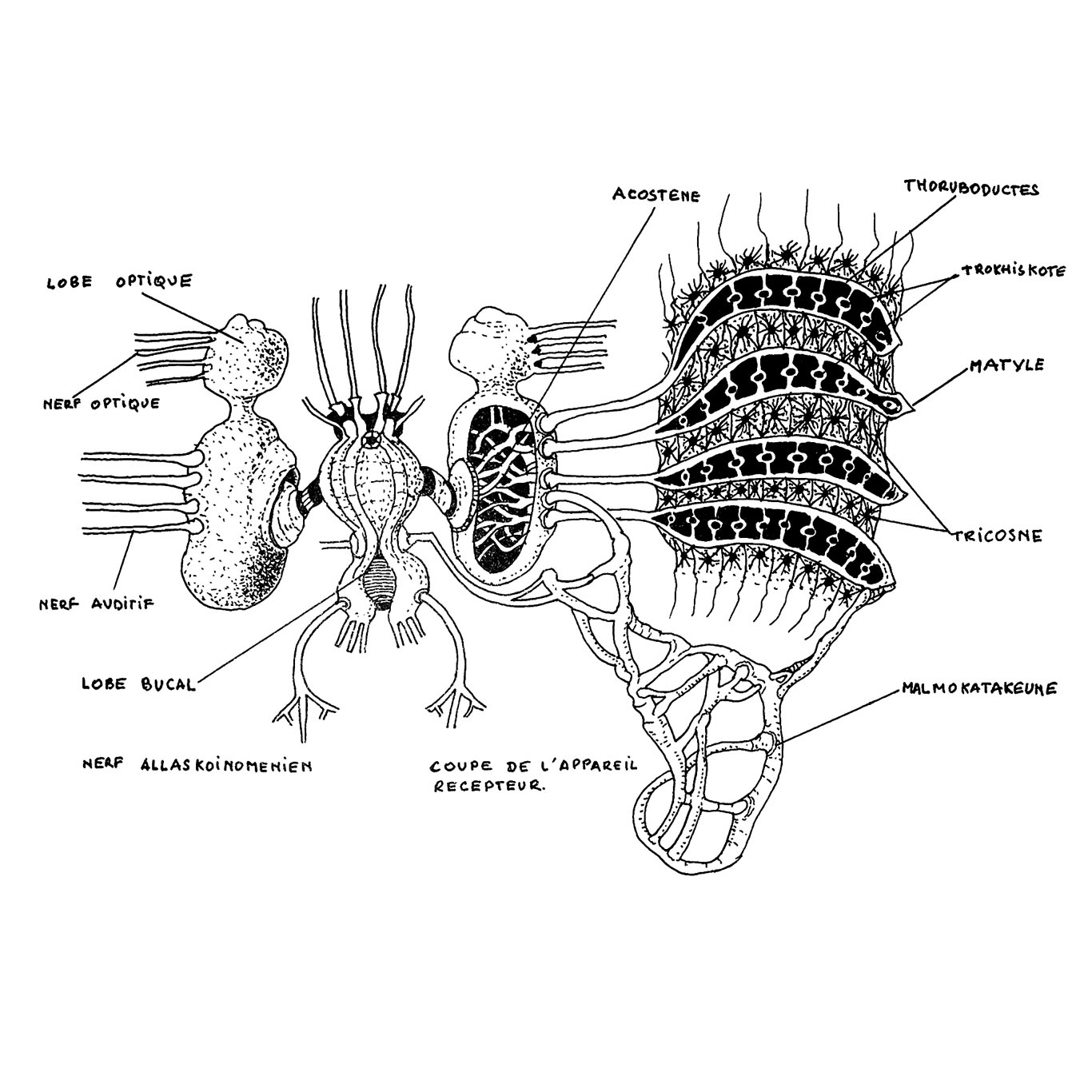

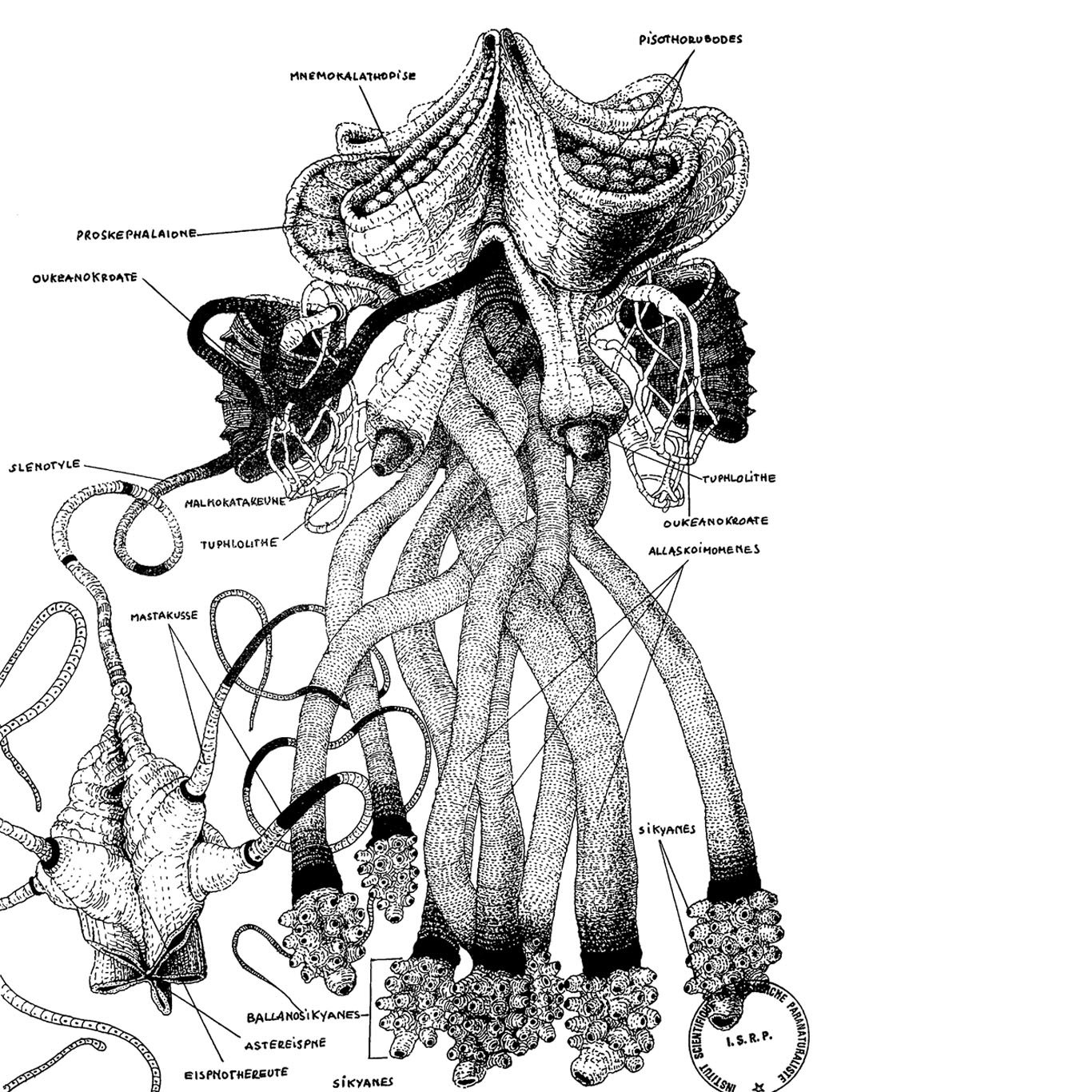

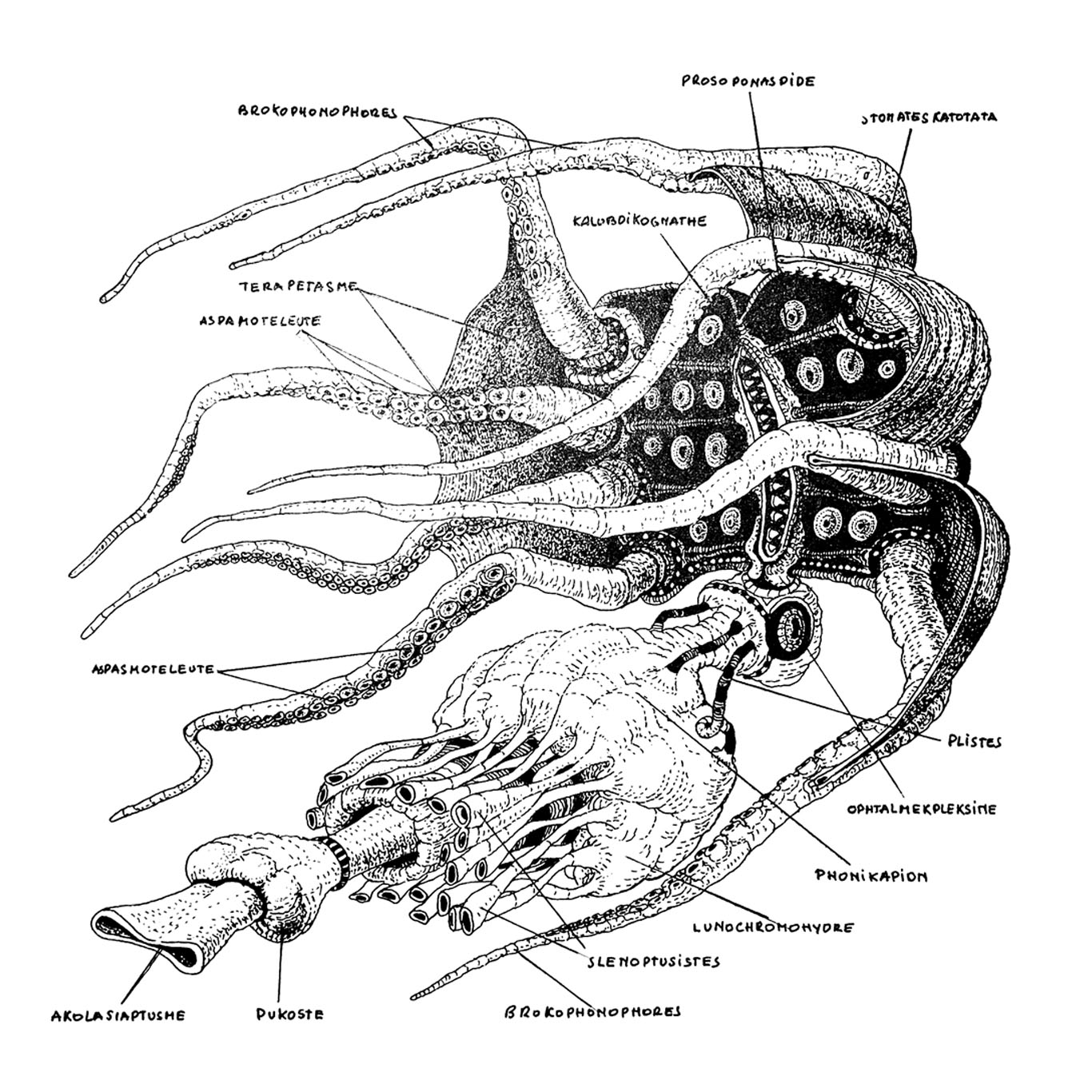

Vilém Flusser & Louis Bec, Vampyroteuthis infernalis [1981–1987], trad. de l’allemand par Christophe Lucchese, Bruxelles, Zones Sensibles, 2015

Exposition « Deep Sea Creations », 2019

Yves Citton, « Naviguer ou filtrer. Vilém Flusser et l’alternative vampirique de l’imaginaire numérique », Hybrid, no 3, 2016

Sonder les abysses : vers un monde vampyroteuthique

- Poulpe des abysses comme double inversé de l’être humain

- Nous ne sommes pas équipés pour affronter les technologies contemporaines

- Invention de « para-natures » permettant de provoquer

de nouvelles idées

5 —

Mutations et contre-pouvoirs

de l’art et du design

5.1 —

Responsabiliser l’injonction

à l’efficacité

Responsabiliser l’injonction à l’efficacité

- Génération de contenus personnalisés (Netflix, 2017)

- Analyse de « parcours utilisateurs » au sein de contextes marchands (Adobe)

- Détection de passagers ivres (Uber, 2018)

- Détection du genre d’une personne aux check-in des aéroports (Detroit, USA, 2018)

- « Robots recruteurs » (Corée du Sud, 2018)

« Is Artificial Intelligence Permanently Inscrutable? », Nautilus, 2016

« Hey Google, sorry you lost your ethics council, so we made one for you »

5.2 —

Désautomatiser l’art

et le design

Adobe Sensei, 2016

TheGrid.io, 2016

The Next Rembrandt, Microsoft, 2018

Zalando, Fashion-MNIST dataset (60 000 sprites)

Balenciaga AI, Robbie Barrat, 2018

« Made in Machina/e », 2018

5.3 —

Déjouer l’opacité

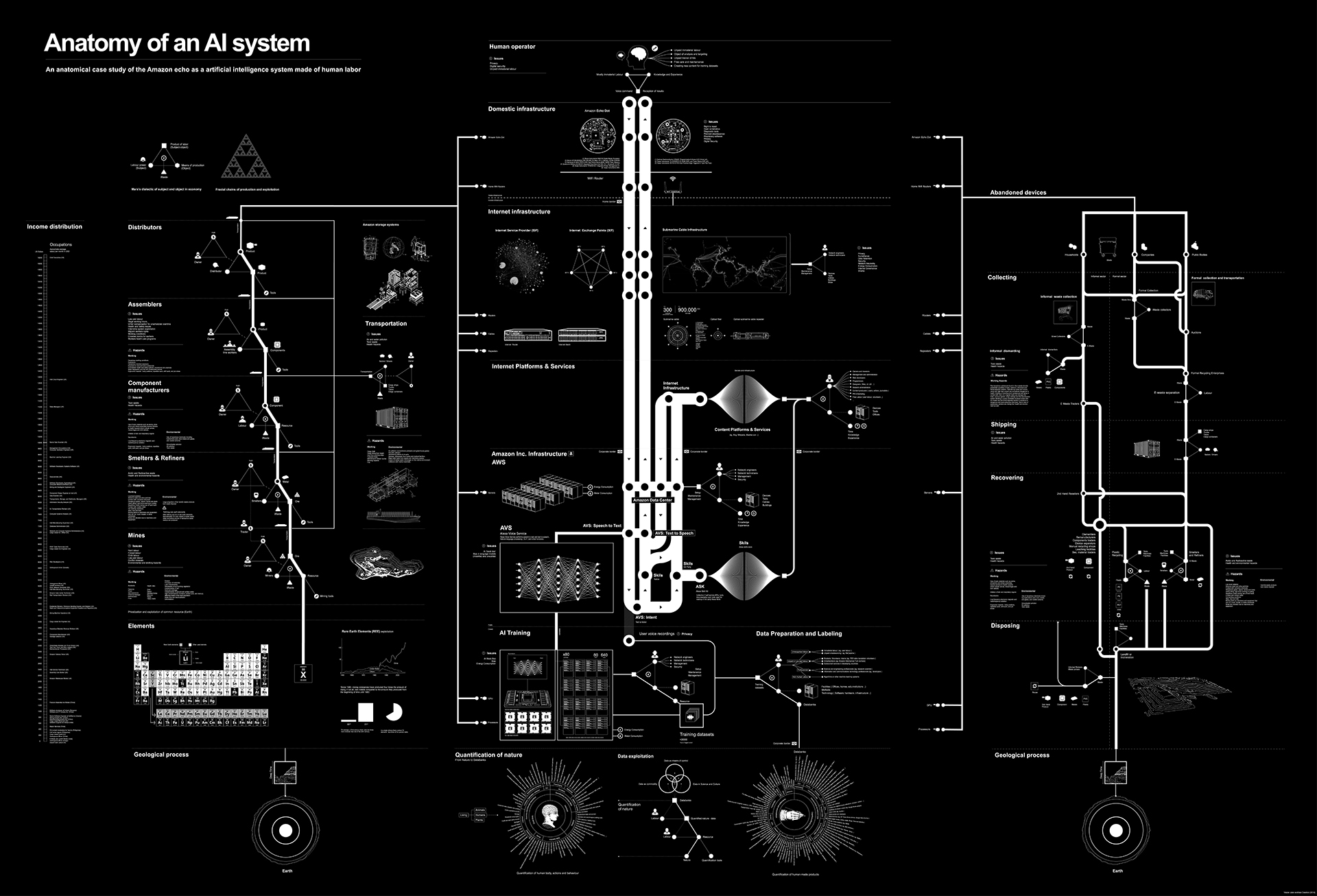

Kate Crawford, Vladan Joler, « Anatomy of an AI System » [Amazon Echo], 2018

Alistair McClymont & John Fass, « Of Machines Learning to See Lemon », 2018

« Ce processus de classification invisible vise habituellement à produire des décisions automatisées, qui peuvent avoir de lourdes conséquences sur les libertés individuelles et collectives. Les possibles avantages de l’apprentissage machine [machine learning] sont nombreux, mais nous courons le risque de développer des technologies d’une telle complexité que notre capacité à les façonner pour servir le bien commun devient très limitée. »

— Alistair McClymont & John Fass, « Of Machines Learning to See Lemon », 2018

Jennifer Lyn Morone, « Reclaiming the Corporate Owned Self », 2017

Raphaël Bastide, Twins, performance, 2016

— Conclusion

Les humanités numériques face aux machines du deep learning

Les DH face aux machines du deep learning

- La machine, en creux, définit ce que l’être humain n’est pas

- Les capacités cognitives humaines s’entrelacent avec les technologies computationnelles

- L’opacité intrinsèque aux IA du deep learning invite à abandonner les idées de contrôle et de maîtrise

Les DH face aux machines du deep learning

- Penser les « humanités numériques » sans l’humanisme ?

- Repenser les humanités numériques au regard des

digital & cultural studies

@AnthonyMasure

www.anthonymasure.com

—

Présentation réalisée avec Reveal.js, MIT License

Police de caractère : IBM Plex, Mike Abbink pour Bold Monday, 2018

—

Licence des textes : CC BY–SA